Vortrag am 14.12.2007

Karl Mannsfeld (Dresden), Mitglied der Mathematisch-naturwissenschaftlichen Klasse:

Dr. habil., Professor i. R. für Landschaftslehre/Geoökologie, seit 6/1998 Projektleiter des Vorhabens „Naturhaushalt und Gebietscharakter” der SAW, am 14. Februar 1997 zum Ordentlichen Mitglied der Mathematisch-naturwissenschaftlichen Klasse gewählt.

Arbeitsschwerpunkte: Landschaftsökologie, Bodenkunde, Hydrogeographie.

Landschaftsökologische Forschung an der Sächsischen Akademie der Wissenschaften zu Leipzig (1965–2007)

Das Forschungsprojekt „Naturhaushalt und Gebietscharakter“ wurde im September 1965 durch staatliche Förderung bei der SAW eingerichtet. Die Arbeitsstelle, zunächst unter Leitung von Prof. Dr. E. Neef, hatte ihren Sitz in Dresden. Nach 1990 wurde das Vorhaben in das Akademieprogramm integriert und eine Laufzeit bis Ende 2007 festgelegt.

Zum Gründungszeitpunkt gab es verstärkte Bemühungen der geographischen Fachdisziplin, den komplexen Wirkungszusammenhang der uns umgebenden natürlichen und gebauten Umwelt zu erfassen und die stofflichen Veränderungen im landschaftlichen Gefüge bilanzmäßig zu erfassen. Die Gesamtheit dieser Beziehungen fasste man als Lehre vom Landschaftshaushalt oder als Landschaftsökologie zusammen. Bereits der Name des Forschungsprojektes signalisierte programmatischen Hintergrund. Eine subtile Analyse der Naturbedingungen sollte für Raumausschnitte der Erdoberfläche eine Bewertungsgrundlage sein, um der Gesellschaft über Nutzbarkeit, Schutzwürdigkeit u.a. auch planerisch umsetzbare Informationen anzubieten.

Rückblickend ragen aus den weitgefächerten Untersuchungsgebieten der Arbeitsgruppe vier Schwerpunkte heraus.:

- Im Zeitraum bis etwa 1970/75 wurden wesentliche theoretische Einsichten zu Strukturgesetzen landschaftlicher Ökosysteme gewonnen und in Testgebieten ebenso erprobt wie auch methodische Beiträge zur landschaftsökologischen Raumanalyse geleistet. So konnte später auf dieser Basis zwischen 1994 und 2000 ein naturräumliches Landeskartenwerk für Sachsen im Auftrag des Umweltministeriums vorgelegt werden, was in dieser Form in keinem anderen Bundesland existiert.

- Mit Beginn der 80er Jahre wurden die Grundlagenkenntnisse zunehmend auf gesellschaftliche Nutzungsvorgänge bezogen. Als methodisches Schlüsselkriterium wurde das von HAASE erarbeitete Konzept der Naturraumpotentiale und Landschaftsfunktionen weiterentwickelt und in diesem Zusammenhang auch eine verstärkte Forschung zu den Neben- und Folgewirkungen gesellschaftlicher Eingriffe in den Stoff- und Energiehaushalt von Landschaftsräumen durchgeführt.

- Deshalb wurden im Zeitraum zwischen 1985 und 2005 auch mehrfach vertragliche Vereinbarungen mit Praxispartnern eingegangen. Neben dem o.g. Landeskartenwerk ragen diesbezüglich Beiträge zum Ressourcenschutz für ein Anbaugebiet im Plantagenobstbau, zur Erkundung und Vermeidung von Stickstofffrachten aus diffusen Quellen für den Boden und das Grundwasser oder EU-Projekte zur Entwicklung von Agrar-Umweltmaßnahmen heraus.

- Parallel dazu befasste sich die Arbeitsgruppe in den vergangenen 10 Jahren mit Konzepten zur landschaftsökologischen Umweltbeobachtung (Monitoring) bei der Erfassung und Dokumentation von Landschaftsveränderungen. Das daraus ab dem Jahre 2000 formulierte Generalthema „Langzeituntersuchungen von Landschaftsveränderungen“ widmete sich vorrangig dem Entwurf landschaftlicher Leitbilder, die als regionale Umweltqualitätsziele der Regional- und Landschaftsplanung notwendige Vorgaben zur Raumentwicklung mit Kriterien wie Belastbarkeit und Tragfähigkeit anbieten.

Die Forschungsgruppe hat sich im Verlaufe der 42 Jahre ihres Bestehens auf dem Felde landschaftsökologischer, umweltbezogener und besonders anwendungsorientierter geographischer Forschung in Deutschland einen guten Namen gemacht, der auch durch eine überaus reiche Publikations- und Vortragtätigkeit begründet worden ist.

Trotz einer überaus positiven externen Begutachtung hat die Wissenschaftliche Kommission der Union in Mainz einen gemeinsam mit Prof. Lentz (OM) ausgearbeiteten Neuantrag abgelehnt, so dass das Laufzeitende zugleich das Ende landschaftsökologischer Forschung durch die Physische Geographie an der Sächsischen Akademie der Wissenschaft zu Leipzig bedeutet.

Vortrag am 14.12.2007

Detlef Altenburg (Weimar-Jena), Mitglied der Philologisch-historischen Klasse:

Dr. phil., seit 1999 Professor für Musikwissenschaft an der Hochschule für Musik „Franz Liszt“ Weimar, Direktor des Gemeinsamen Instituts für Musikwissenschaft der Hochschule für Musik „Franz Liszt“ Weimar und der Friedrich-Schiller-Universität Jena, am 10. März 2006 zum Ordentlichen Mitglied der Philologisch-historischen Klasse gewählt.

Arbeitsgebiete: Musik in der Hofkultur des 17. und 18. Jahrhunderts; Musikalische Aufführungspraxis im 17. und 18. Jahrhundert; Musik und Musikanschauung im 19. Jahrhundert (u.a. Franz Liszt, Neudeutsche Schule, Programmusik, Schauspielmusik); Musik und kulturelle Identität.

Leben mit den Klassikern: Musikalische Wege der Rezeption von Oper und Drama im 19. Jahrhundert

Das Phänomen der ‚Vernutzung‘ von großer Kunst ist eines der Phänomene, die Puristen unter den Musikliebhabern seit den 1970er Jahren zunehmend beklagen und als eine Folge der Umfunktionalisierung von Musik im Zeitalter ihrer unbegrenzten technischen Reproduzierbarkeit betrachten. Vivaldis Jahreszeiten beim Shopping, Smetanas Moldau als Geräuschkulisse im Restaurant und Haffner-Symphonie zur Sektwerbung – die Klassik ist mit uns, ja sie verfolgt uns bisweilen bis in die entferntesten Winkel unserer Existenz.

Das Phänomen ist indes keineswegs neu, sondern schon Heine beklagte genau diesen Verschleiß großer Kunst im Hinblick auf das sich verselbständigende Eigenleben, auf die fragmentierte Rezeption des Freischütz. Tatsächlich sind diese Fragmentierungen ein wesentliches Element der Opernrezeption im 19. Jahrhundert. Sie reichen von der Klavierbearbeitung der schönsten Arien für den häuslichen Gebrauch über die im Männerchorwesen der Zeit beliebten Opernchöre, die wie im Falle der Jägerchöre aus dem Freischütz zum Triumph des deutschen Waldes und des Sieges von Belle Alliance zugleich werden konnten. Und nicht zuletzt führte die Opernarie lange vor Erfindung des Transistorradios ihr Eigenleben in den sonntäglichen Promenadenkonzerten von Bläserensembles, zunächst noch der Hofoboistenkorps und später zunehmend der Militärkapellen der Garnisonsstädte und der Kurkapellen. Eine ungleich anspruchsvollere Variante der Rezeption großer Kunst bildeten die Opernparaphrasen, die Franz Liszt in schöpferischer Auseinandersetzung mit Schlüsselszenen von Opern seiner Zeitgenossen als eine Art virtuelle Focussierung der inneren Handlung konzipierte.

Im Hinblick auf die Oper ist das Phänomen in der Musikwissenschaft seit langem bekannt. Die Tatsache, dass eine ganz analoge Form der Rezeption auch im Hinblick auf das Drama der Goethezeit existierte, wurde sowohl in der Musikwissenschaft als auch in der Literaturwissenschaft lange übersehen. Die Überlegungen zu dieser Form der Dramenrezeption sind Ergebnis des Teilprojektes Musik und Theater des Sonderforschungsbereichs 482 Ereignis Weimar-Jena. Kultur um 1800. Im Gegensatz zu den Assoziationen, die der Begriff Sprechtheater weckt, war um 1800 und bis weit ins 19. Jahrhundert hinein Musik ein wesentlicher Bestandteil der Aufführung von Dramen. Musik erklang zu Beginn, zwischen den Akten und nicht selten auch am Schluss der Aufführung. Vor allem aber sahen viele Dramatiker, unter ihnen insbesondere auch Goethe, Schiller und Kotzebue, in ihren Dramen Bühnenmusik vor. Die von Hellmut Flashar vor einigen Jahren hier in der Akademie vorgestellte Musik von Felix Mendelssohn Bartholdy war keine Ausnahme, sondern nur ein besonders herausragendes Beispiel einer gängigen Theaterpraxis. Diese Schauspielmusiken konnten ihrerseits ein ganz eigenständiges Nachleben entwickeln. Teils überdauerten sie wie im Falle von Schuberts Rosamunde-Musik im Konzertsaal die Bezugsdramen selbst. Teils wurden ihre Chöre zum Bestandteil des Repertoires der Männerchöre und wurden zum Bildungsgut breitester Bevölkerungsschichten. Vereinzelt gelangten derartige Bühnengesänge gar zu einer derartigen Popularität, dass sie zum Volkslied wurden. Die Schere, die sich zwischen dem hohen Anspruch eines multimedial konzipierten Dramas und der fragmentierten Rezeption auftut, wirft die grundsätzliche Frage auf, inwieweit die beiden Rezeptionsformen sich gegenseitig bedingen.

Vortrag am 9.11.2007

Ernst Schubert (Halle), Mitglied der Philologisch-historischen Klasse:

Dr. phil. habil., Professor i. R. für Kunstgeschichte; seit 11. Oktober 1991 Ordentliches Mitglied der Philologisch-historischen Klasse; Domherr und Dechant des Domkapitels der Vereinigten Hochstifte zu Merseburg und Naumburg und des Kollegiatstifts Zeitz a. D.; Ehrenvorsitzender der Historischen Kommission Sachsen-Anhalt; Vorsitzender der Projektbegleitenden Kommission „Die deutschen Inschriften des Mittelalters und der frühen Neuzeit”.

Zwölf Bildgrabmäler des hohen Mittelalters und die Erforschung der Memoria

Nach einer kurzen, den Begriff Memoria erklärenden Einführung werden die Memoria-Offizien, die rituellen Handlungen, zusammenfassend erläutert, die im Mittelalter und bis in die Neuzeit hinein am Grabe vorgenommen und in der Regel jährlich am Todestag wiederholt wurden. Eine im hohen Mittelalter noch relativ seltene Sonderform des Grabmals ist das Bildgrabmal, mit dem bei Handlungen am Grabe nicht nur, wie üblich, der Name, sondern auch ein Bild des Verstorbenen evoziert wurde. Die Forschung geht davon aus, daß die Memoria für die Entstehung auch dieser besonders repräsentativen Gestaltung des Grabmals die Veranlassung gab.

Zum Verständnis der Entstehung und Gestaltung des Bildgrabmals im hohen Mittelalter werden dann zwölf Grabmäler interdisziplinär analysiert und interpretiert. Die bildlichen Darstellungen dieser Grabmäler decken stilgeschichtlich und geistesgeschichtlich den Zeitraum von der Früh- bzw. Hochromanik über die Spätromanik bis zur Früh-, Hoch- und beginnenden Spätgotik ab. Ihre Darstellungsformen sind also verschieden stilisiert. Die Verstorbenen sind nicht nur unterschiedlich dargestellt, sie sollten auch unterschiedlich gesehen und erlebt werden, und zwar so, wie sie in der Darstellung stilisiert sind.

Aus dieser interdisziplinären Erforschung der Bildgrabmäler ergeben sich neue Denkansätze: Die Repräsentation war und blieb mindestens bis zum Beginn der frühen Neuzeit in der zweiten Hälfte des 15. Jahrhunderts die vordergründige Absicht bei der Herstellung von Bildgrabmälern, die deshalb wohl immer zugleich Denkmäler waren. Ihre Auftraggeber verfolgten mit diesen Denkmälern nachweisbare politische, kirchliche, juridische und ökonomische Ziele. Das individuelle Bildnis, das wirklichkeitsnahe Porträt, blieb eine ganz seltene Ausnahme. Für die Memoria mußte man zwar die Stelle, wo der Tote begraben liegt, kennen, nicht aber sein Aussehen auf Erden. Ein Grabmal mit dem Bilde des Verstorbenen brauchte man für die Memoria nicht.

Unbedingte Voraussetzung für die Beantwortung der Frage nach der Entwicklung zur Wirklichkeitsnähe der Darstellungen auf Bildgrabmälern bis hin zur Entstehung des Porträts ist die Beantwortung der Frage nach der Absicht und der Fähigkeit der einzelnen Epochen des Mittelalters, das individuelle Bild eines bestimmten Menschen zu erfassen und zu reproduzieren. M. E. wäre man zum Porträt vermutlich immer in der Lage gewesen, wenn man es gewollte hätte und hätte wollen können. Aber man hat es im hohen Mittelalter offensichtlich gar nicht gewollt und vielleicht nicht einmal wollen können.

Die hochmittelalterlichen Bildgrabmäler wurde nicht mit der Absicht geschaffen, die Verstorbenen in persona zu evozieren, wie sie ausgesehen haben, und die Memoria war für die Entstehung des Bildgrabmals m. E. nicht veranlassend, nicht konstitutiv. – Der moderne Mensch verhält sich am Grabe bekanntlich ganz anders. Warum wohl?

Vortrag am 9.11.2007

Wilfried Hofmann (Dresden), Mitglied der Technikwissenschaftlichen Klasse:

Dr.-Ing., Professor für Elektrische Maschinen und Antriebe an der Technischen Universität Dresden; bis 2007 Professor für Elektrische Maschinen und Antriebe an der Technischen Universität Chemnitz; am 10. März 2006 zum ordentlichen Mitglied der Technikwissenschaftlichen Klasse gewählt.

Hauptarbeitsgebiete: Elektromagnetische Energiewandler insbes. Entwurf und Analyse von PM-Synchronmaschinen; Energiewandler für regenerative Energien (Wind) insbes. Regelung doppeltspeisender Generatoren; Mechatronik und Bewegungssteuerungen insbes. Entwurf und Regelung von Magnetlagern und Direktantrieben sowie energieeffizienten Hybrid- und Elektrofahrzeugantrieben; Leistungselektronik insbes. Steuerverfahren für Frequenzumrichter.

Der Leistungsbypass – ein erfolgreiches Prinzip in modernen elektromechanischen Energiewandlern

Der Bypass, auch Nebenweg oder Verzweigung, ist keine Erfindung der Energietechnik, sondern bekannt aus Medizin, Verkehrstechnik, Digitaltechnik und nicht zuletzt aus der allgemeinen Elektrotechnik. Dem Leistungsbypass in der elektrischen Energietechnik kommt neben der einfachen Anpassungsfunktion an unterschiedliche Ein- und Ausgangsparameter der Leistungskenngrößen die Aufgabe zu, einen Steuereingriff über den energieärmeren Nebenpfad zu ermöglichen und damit das Wandlersystem drehzahlvariabel zu machen.

In der Energietechnik insbesondere Windenergieanlagen empfiehlt es sich, Leistungsbypässe rein mechanisch über Hydrowandler, elektromechanisch über zwei Elektromaschinen oder rein elektrisch in doppeltspeisenden Windgeneratoren zu nutzen. Letztere sind in der Megawatt-Klasse moderner Windenergieanlagen mit über 80% Anteil weltweit dominierend. Das Potential dieser Systeme in bezug auf Energieeffizienz, Netzverträglichkeit, Steuerbarkeit und Ausbaufähigkeit in off-shore Standorten sowie Stärken und Schwächen gegenüber direkten Energiewandlern werden erläutert. Das Prinzip der Leistungsverzweigung hat aber auch Einzug gehalten in die konventionelle Kraftwerkstechnik wie in Pumpspeicherwerken, wo durch den steuerbaren Bypass mit Hilfe einer leistungsärmeren Leistungselektronik durch Halbleiterventile (Thyristoren) Leistungen über 300 MW motorisch (Pumpenbetrieb) oder generatorisch (Turbinenbetrieb) dosiert werden können.

Mit der prinzipiellen Umkehrbarkeit der Energieflussrichtung in modernen elektromechanischen Energiewandlern eröffnet sich mit der Antriebstechnik ein zweites Anwendungsfeld. Aktuelle Beispiele dafür lassen sich im Antriebsstrang von Hybridfahrzeugen finden. Die herkömmliche Verbrennungsmaschine (Benzin- oder Dieselmotor) muss wegen ihrer nichtidealen Drehzahl-Drehmomentkennlinie über ein Getriebe (Schalt- oder Automatikgetriebe) an das Fahrprofil angepasst werden. Bei stufenlos einstellbarer Übersetzung hilft ein rein elektrischer Bypass, bestehend aus 2 Elektromaschinen und einem Planetengetriebe. Dies stellt zugleich eine intelligente Kombination von Parallel- und Serienhybrid dar und gestattet außerdem einen Energiespeicher, Batterie und/oder Superkondensator, anzuschließen. Am Beispiel eines Mittelklassefahrzeugs werden die Eigenschaften erläutert und Ergebnisse zur Energieeffizienz diskutiert.

Zum Abschluss des Vortrags werden für leistungsverzweigende Energiewandler die wichtigsten technischen Eigenschaften wie Energieeffizienz, Masse, Bauvolumen, Aufwand und Kosten zusammengefasst und ein Ausblick auf zukünftige Entwicklungen gegeben.

Vortrag am 12.10.2007

Eugen Georg Woschni (Dresden), Mitglied der Technikwissenschaftlichen Klasse:

Dr.-Ing., Professor i. R. für Nachrichtentechnik an der Technischen Universität Chemnitz; am 11. Oktober 1985 zum Ordentlichen Mitglied der Mathematisch-naturwissenschaftlichen Klasse gewählt; Mitglied des Ehrenrates, Mitglied der Strukturbezogenen Kommissionen für Technikfolgenabschätzung, Umweltprobleme und Wissenschaft und Werte.

Hauptarbeitsgebiete: Elektrotechnik/ Elektronik, Informationstechnik.

Ein Jahrhundert Informationstechnik wird besichtigt

Nur wenige Gebiete der Technik haben im letzten Jahrhundert eine derart stürmische Entwicklung zu verzeichnen wie das Gebiet der Informationstechnik. Im vorliegenden Beitrag wird die Entwicklung dargestellt, wobei insbesondere zwei Perioden mit jeweils typischen Kennzeichen unterschieden werden können:

Die Zeit bis zur Mitte des vorigen Jahrhunderts war gekennzeichnet durch die Möglichkeit, kleinste Spannungen fast beliebig zu verstärken und Nachrichten drahtlos zu übertragen.

In der zweiten Hälfte des vorigen Jahrhunderts gewann zusätzlich der Einsatz von intelligenten Systemen bei gleichzeitiger extremer Miniaturisierung zunehmende Bedeutung, wie bereits ein sehr einfaches Beispiel zeigt: Will man die Reichweite eines Radargerätes verdoppeln, so muss man nach der klassischen Theorie die Sendeleistung versechzehnfachen! Die Energie pro Flächeneinheit der Abstrahlung nimmt nämlich wegen der quadratischen Zunahme der Fläche mit der Entfernung ebenfalls quadratisch ab. Dasselbe gilt für die vom zu messenden Objekt reflektierte Strahlung, so dass der Faktor 4 x 4 = 16 entsteht. Eine so große Erhöhung der Leistung ist jedoch nicht machbar, ganz abgesehen von den Energiekosten. Es muss also anstelle der Erhöhung der Energie Intelligenz eingesetzt werden, wie auch sonst im täglichen Leben. Genau dies erreichen die Verfahren zur Signalerkennung, wenn das Signal so klein wird, dass es im immer vorhandenen Rauschen untergeht. So ist es heute möglich, so schwache Signale aus dem Rauschen herauszufiltern wie z. B. bei der Sonde „Pioneer 10”. Sie erreichte 1983 nach 11 Jahren Flug mit 5109 km Entfernung die Grenze unseres Sonnensystems und es bestand Funkverbindung, obwohl die Sendeleistung mit 10 Watt nur der einer brennenden Kerze entsprach.

Nach einführenden grundsätzlichen Bemerkungen wird im ersten Hauptteil ein Überblick über die historische Entwicklung an Hand typischer Beispiele gegeben. Dabei werden einerseits die charakteristischen Entwicklungstendenzen herausgearbeitet, andererseits einige kuriose Anwendungen und Schlussfolgerungen gezogen. Im zweiten Hauptteil wird auf in letzter Zeit durchgeführte eigene Untersuchungen zu Fragen der Frequenzmessung eingegangen, über die bereits auf internationalen Kongressen berichtet werden konnte.

Die Ausführungen lassen die stürmische Entwicklung des Fachgebietes erkennen, die zweifellos angesichts der weiteren Miniaturisierung mit der daraus folgenden Steigerung der Rechengeschwindigkeit und der Verschmelzung verschiedener Wissenschaftsgebiete wie der Mikrosystemtechnik weiter anhalten wird.

Vortrag am 12.10.2007

Jost Heintzenberg (Leipzig), Mitglied der Mathematisch-naturwissenschaftlichen Klasse:

Dr. rer. nat., Professor für Physik der Atmosphäre an der Universität Leipzig; Leiter des Leibniz-Instituts für Troposphärenforschung Leipzig; am 12. Januar 1996 zum Ordentlichen Mitglied der Mathematisch-naturwissenschaftlichen Klasse gewählt; Mitglied der Strukturbezogenen Kommissionen für Umweltprobleme und Wissenschaft und Werte.

Hauptarbeitsgebiete: experimentelle Untersuchungen atmosphärischer Aerosole und Wolken, die auf deren Bildung, Umwandlung und deren Einfluß auf Energiebilanz, Wasserkreislauf und Luftqualität gerichtet sind.

Physikalische Wolkenforschung am Leibniz-Institut für Troposphärenforschung

Motivationen für Wolkenforschung lassen sich in vielen Wissensdisziplinen und Lebensbereichen finden. Wolken sind wichtig für die Energiebilanz der Erde, für den Wasserkreislauf, für die Reinigung der Atmosphäre aber auch für unsere ästhetischen Bedürfnisse.

Das Leipziger Leibniz-Institut für Troposphärenforschung (IfT) widmet sich seit seiner Gründung 1992 neben der Erforschung des atmosphärischen Aerosols auch den damit eng zusammenhängenden Wolken. Der Grund dafür liegt in diesem engen Zusammenhang, weil der Mensch durch seine Aerosolemissionen die Wolken beeinflusst und dieser Einfluss im Zusammenhang mit anderen menschlichen Klimaeinflüssen zu quantifizieren ist.

Das breite Spektrum von Wolkenforschung am IfT umfasst chemische, numerisch modellierende und physikalische Ansätze. Der Vortrag konzentriert sich auf die physikalische Wolkenforschung, beginnend mit Laboruntersuchungen. Diese werden durch Arbeiten in dem 2006 eröffneten Leipziger Wolkenlabor mit experimentellen Simulationen im wasserdampfuntersättigten und -übersättigten Bereich vorgestellt.

Da im Labor nur ein Teil der vielen Wolkenprozesse nachgestellt werden kann, sind Feldexperimente unumgänglich, um die Skala der untersuchten Prozesse auf die realistischer Wolken auszudehnen. Dazu wird das fliegende Wolkenlabor mit ersten Ergebnissen zu turbulenten Wolkenprozessen gezeigt, wonach bodengestützte Experimente zu unterkühlten Wolken, die wiederholt auf dem Jungfraujoch stattfanden, diskutiert werden. In einem Ausblick wird die sehr ernste Frage des Geoengineering in Bezug auf Wolken angesprochen.

Vortrag am 8.6.2007

Klaus Arnold (Leipzig), Mitglied der Mathematisch-naturwissenschaftlichen Klasse:

Dr. rer. nat. habil., Professor für Medizinische Physik und Biophysik an der Universität Leipzig; am 3. Juni 1988 zum Ordentlichen Mitglied der Mathematisch-naturwissen-schaftlichen Klasse gewählt.

Hauptarbeitsgebiete: Molekulare Biophysik, Membran-Biophysik, Zelluläre Biophysik, Rheumatoide Arthritis und Arteriosklerose.

Untersuchungen zu den Schädigungsmechanismen von Phospholipiden bei Arteriosklerose: Lipid-Analytik mittels MALDI-TOF Massenspektrometrie und 31P-NMR-Spektroskopie

Die Arteriosklerose ist eine weltweit – insbesondere in den Industrienationen – sehr häufig vorkommende Erkrankung. Ihre Entstehung wird u.a. durch ungesunde, fettreiche Ernährung, zu wenig Bewegung und Rauchen gefördert.

Die Erkrankung ist primär dadurch charakterisiert, daß es zur Ablagerung der sogen. arteriosklerotischen Plaques in den Blutgefäßen kommt („Verschlußkrankheit”). Obwohl die genauen Mechanismen, die zur Entstehung dieser Plaques führen, noch nicht vollständig verstanden sind, wird gegenwärtig folgender Ansatz favorisiert: Der Transport unpolarer (und damit in Wasser bzw. in Blut unlöslicher) Fette wie z.B. Cholesterylester oder Triacylglycerole erfolgt im Körper durch die sogen. Lipoproteine. In diesen Lipoproteinen sind unpolare Fette durch Umhüllung mit polareren Fetten (den Phospholipiden) und Proteinen „wasserfreundlich verpackt”. Dabei kann das „gute” Lipoprotein (HDL) und das „schlechte” Lipoprotein (LDL) unterschieden werden.

Unter dem Einfluß reaktiver Sauerstoffverbindungen („reactive oxygen species”, ROS), die im erkrankten Organismus über das normale Maß hinaus gebildet werden, unterliegen diese Lipoproteine einer Oxidation. Diese oxidativ-modifizierten Lipoproteine werden in der Folge von körpereigenen Abwehrzellen, z.B. den Makrophagen als „fremd” eingestuft und phagozytiert, d.h. „aufgefressen”. Damit nehmen die Zellen aber auch eine übermäßig große Menge an Cholesterol auf, das in den Lipoproteinen enthalten ist. Dadurch quellen die Makrophagen auf und werden zu „Schaumzellen”. In Gegenwart bestimmter Salze bilden diese Schaumzellen die Vorstufe für arteriosklerotische Plaques. Somit besitzt die Untersuchung der Oxidationsprozesse von Lipiden als ein wichtiger Primärschritt bei der Pathogenese der Arteriosklerose hohe medizinische Relevanz.

Im Vortrag werden die in vivo relevanten Bildungsreaktionen von ROS (mit dem Schwerpunkt auf enzymatisch generierter Hypochlorsäure, HOCl) sowie deren Reaktionen mit physiologisch-relevanten Lipiden auf verschiedenen Komplexitätsebenen (isolierte Lipide und Lipoproteine) diskutiert. Als wichtigstes analytisches Verfahren wird dabei neben Methoden der kernmagnetischen Resonanz (NMR) vor allem das Verfahren der „matrix-assisted laser desorption and ionization time-of-flight” Massenspektrometrie (MALDI-TOF MS) besprochen, da dieses moderne Analyseverfahren (Nobelpreis 2002) viele Vorteile für die Lipidanalytik besitzt und sich außerdem durch eine sehr hohe Empfindlichkeit auszeichnet. Es wird dargelegt, wie auf diese Weise neue, bislang unbekannte Oxidationsprodukte (vor allem Lyso-Phosphatidylcholine) von Lipiden detektiert und strukturell charakterisiert werden konnten.

Vortrag am 8.6.2007

Volker Leppin (Jena), Mitglied der Philologisch-historischen Klasse:

Dr. theol., Professor für Kirchengeschichte an der Friedrich-Schiller-Universitätr Jena; am 10. März 2006 zum Ordentlichen Mitglied der Philologisch-historischen Klasse gewählt.

Hauptarbeitsgebiete: Scholastik und Mystik im späten Mittelalter, Biographie und Theologie Luthers und Zwinglis, Geschichte der Jenaer Theologischen Fakultät (16.–20. Jahrhundert), Religion und Aufklärung.

Die Wittenberger Reformation und der Prozess der Transformation kultureller zu institutionellen Polaritäten

Eine der zentralen Fragen zur Erforschung der Reformation ist die Kontinuität der Prozesse des 16. Jahrhunderts zu den Entwicklungen des späten Mittelalters. Der Vortrag geht dieser Frage in mehren Schritten nach: Zunächst wird die Situation kultureller Polarität im späten Mittelalter nachgezeichnet. Es gibt keine einlinige Entwicklung des Auf- oder Abstiegs hin zur Reformation. Vielmehr ist das späte Mittelalter an verschiedenen Stellen vom Gegeneinanderlaufen der Entwicklungen geprägt. Das gilt für die Theologiegeschichte ebenso wie für Frömmigkeits- und Sozialgeschichte. Eine der wichtigsten Polaritäten des späten Mittelalters ist aber eher institutionen- als kulturgeschichtlich zu fassen: Das sich allmähliche verfestigende Gegenüber von Zentralität und Dezentralität, wie es sich insbesondere in der Frage der Stellung zum Papsttum nachzeichnet, dem in bestimmten theoretischen Diskursen eine immer stärkere Macht zugesprochen wurde, während sich faktisch die Kirchenorganisation immer mehr von einer solchen zentralen Leitung entfernte. Dabei kam es im Römischen Reich nicht zu nationalkirchlichen Entwicklungen, wie sie sich in Ansätzen im französischen Gallikanismus zeigte; wohl aber haben sich einzelne Territorien und Reichsstädte in ihrer kirchlichen Verwaltung immer stärker von einem zentralen Zugriff gelöst.

Der damit vollzogene Zugriff von Laien auf die Kirche erhielt eine dynamische Begründung durch die Lehre vom allgemeinen Priestertum, wie sie von Luther 1520 mit der berühmtem Formulierung „Dan was ausz der tauff krochen ist, das mag sich rumen, das es schon priester, Bischoff und Bapst geweyhet sey” wirksam vertreten wurde. Diese Lehre zeigt, wie aus der theologischen Entwicklung Martin Luthers Gesellschaftsveränderung folgen konnte. Diese Entwicklung selbst vollzog sich nicht bruchartig, sondern als ein allmählicher Transformationsprozess, in dessen Verlauf Luther spätmittelalterlicher Frömmigkeit umbaute.

Die Gesellschaftsveränderung brachte auch eine institutionelle Veränderung mit sich, die vor allem dadurch möglich wurde, dass Reichsstädte und dann ab 1526 auch einzelne Territorien (Sachsen, Hessen) die Gestaltung einer neuen Kirchlichkeit in die Hand nahmen. Das knüpfte an spätmittelalterliche Entwicklungen an, geschah aber nun auf Basis einer grundsätzlich neuen Legitimation durch die neue Lehre. Mit dieser Institutionalisierung ging dann eine Verfestigung konfessioneller Lager in unterschiedenen Blöcken einher.

So zeigt sich, dass Mitte des 16. Jahrhunderts an Stelle einer spätmittelalterlichen Gesellschaft, die in einem institutionellen Rahmen Polaritäten zusammenhielt, eine institutionelle Differenzierung getreten war, die eine grundlegende Polarität als unterschiedliche Konfessionen sichtbar machte.

Vortrag am 11.5.2007

Hans Ulrich Schmid (Leipzig), Mitglied der Philologisch-historischen Klasse:

Dr. phil., Professor für Geschichte der deutsche Sprache und für Historische Sprachwissenschaft an der Universität Leipzig; Mitglied der Vorhabenbezogenen Kommission für die Althochdeutschen Wörterbücher; am 11. Februar 2005 zum Ordentlichen Mitglied der Philologisch-historischen Klasse gewählt.

Arbeitsgebiete: Historische deutsche Sprachwissenschaft mit den Schwerpunkten Historische Syntax, Sprachgeschichte des Ostmitteldeutschen, Sprach- und Überlieferungsgeschichte.

Das neu entdeckte Leipziger Heliandfragment

Vor etwa einem Jahr tauchte völlig überraschend in den Deposita des Thomas-Klosters in der Universitätsbibliothek Leipzig ein Fragment der altsächsischen 'Heliand'-Dichtung auf. Der 'Heliand' ist eine um die Mitte des 9. Jahrhunderts in einem bislang nicht identifizierten norddeutschen Kloster von einem anonymen Autor verfasste poetische Nacherzählung der Evangelien. Der Name des Werkes stammt vom Erstherausgeber Johann Andreas Schmeller und bedeutet so viel wie 'Heiland, Erlöser'. Der altsächsische Dichter hat Stabreimverse, also Alliterationen, verwendet und steht damit – anders als sein Zeitgenosse Otfrid von Weißenburg, der die Evangelien in „moderneren” Endreimversen nachdichtete – noch in der alten germanischen Dichtungstradition. Der 'Heliand' ist das einzige großepische Zeugnis dieser Tradition im deutschen Sprachraum.

Das Werk ist bislang aus zwei (unvollständigen) Codices bekannt. Hinzu kommen einige Fragmente. Das Leipziger Blatt (das in der Forschung mittlerweile die Sigle „L” erhielt) hat im Mai 2006 übrigens ein beträchtliches Medieninteresse gefunden. Es enthält die Erzählung von den Frauen, die zum Grab Jesu gehen und dort nicht den Leichnam des Herrn vorfinden, sondern zwei Engel. Diese Episode ist nur noch in einem der beiden erwähnten Codices enthalten, nämlich der heute in der British Library aufbewahrten Handschrift „C”. Diese ist erst im späteren 10. Jahrhundert in England entstanden, enthält also einen deutlich jüngeren Text mit einem in vielen Details veränderten Sprachstand. Dem Leipziger Fragment, das sehr nahe an die Entstehungszeit des 'Heliand' heranführt, kommt damit erhebliches textgeschichtliches Gewicht zu.

Von besonderem Interesse sind mehrere interlineare Einträge, die ein zeitgenössischer Schreiber vorgenommen hat. Das Besondere daran ist, dass an einer Stelle ein alliterierendes Wortpaar durch ein anderes, ebenfalls stabendes Wortpaar ersetzt ist, was vielleicht sogar an eine Autorkorrektur denken lässt. Es spricht vieles dafür, dass das Leipziger Fragment einmal zu demselben Codex gehörte wie das heute im Deutschen Historischen Museum in Berlin aufbewahrte (ursprünglich in Prag aufgefundene) Einzelblatt „P”. Anlage, Schrift und Sprachstand deuten jedenfalls darauf hin. Dieser im frühen 17. Jahrhundert (am Buchhandelsort Leipzig?) zu Buchbindermakulatur verarbeitete Codex könnte wiederum identisch sein mit jenem ominösen volkssprachigen „Monotessaron”, in dem nach dem Zeugnis Philipp Melanchthons der Reformator Martin Luther „eifrig gelesen” hat, und das diesem als Argument dafür diente, dass die Bibel in deutscher Sprache eine uralte Tradition besitze, die nur von der katholischen Kirche unterdrückt worden sei. Sicher ist, dass Humanistenkreise im ostmitteldeutschen Raum – z.B. Georg Fabricius aus Meißen – einen vollständigen Heliand-Codex in Händen gehalten haben. Die beiden Fragmente „L” und „P” könnten die letzten Überreste davon sein.

Vortrag am 11.5.2007

André Wagenführ (Dresden), Mitglied der Technikwissenschaftlichen Klasse:

Dr.-Ing., Professor für Holz- und Faserwerkstofftechnik an der Technischen Universität Dresden, Geschäftsführender Direktor des Instituts für Holz- und Papiertechnik, am 10. März 2006 zum Ordentlichen Mitglied der Technikwissenschaftlichen Klasse gewählt.

Arbeitsgebiete: Struktur-Eigenschaftsbeziehungen lignocelluloser Stoffsysteme, Technologie des Holzes und der Holzwerkstoffe, Holzvergütung.

Die strukturelle Anisotropie von Holz als Chance für technische Innovationen

Holz zählt zu den ältesten technischen Werkstoffen. Bis Anfang des 20. Jahrhunderts war es der dominierende Konstruktionswerkstoff auf den verschiedensten Gebieten, insbesondere im Fahrzeug-, Schiff- und Flugzeugbau. Holz ist ein von der Natur optimierter zellular aufgebauter Hochleistungsverbundwerkstoff aus Cellulose, Hemicellulose und Lignin mit spezialisierten Zellen und Stoffeigenschaften, die in vielen Fällen denen konkurrierender Werkstoffe überlegen sind.

Standort-, wuchs- und holzartenbedingt prägen sich bei Holz eine Eigenschaftsvielfalt und Eigenschaftsschwankungen aus, die oft nur verbal mit Inhomogenität und Form- bzw. Strukturanisotropie beschrieben werden. Um das stoffliche Wertschöpfungspotential von Holz optimal ausnutzen zu können, sind grundlegende Kenntnisse seiner anatomischen Struktur, seines chemischen Aufbaues, seiner physikalischen Eigenschaften und deren Auswirkungen auf die Technologie des Holzes und der Holzwerkstoffe notwendig. Nur durch eine komplexe Betrachtung dieser Merkmale und Eigenschaften in verschiedenen, voneinander abhängigen Hierarchieebenen ist es möglich, Holz nicht nur als Bau- und Werkstoff zu verstehen, sondern auch als einen nachwachsenden Rohstoff mit noch weitgehend ungenutztem Innovationspotential.

Die Auswirkungen der strukturellen Anisotropie lässt sich neben der Berücksichtigung bei der beanspruchungsgerechten Auslegung bzw. Optimierung von Holzwerkstoffen auch bei der spanlosen Holzbearbeitung – hier am Beispiel der Umformung von Furnier – erklären. Die besonders große plastische Verformbarkeit des Druckholzes, ein Sondergewebe der Nadelhölzer, ohne signifikante Materialschädigung soll die dreidimensionale Verarbeitung von Furnieren mit hohen Verformungsgraden ermöglichen. Dabei dienen die Struktur-Eigenschaftsbeziehungen des biologischen Materials als Vorbild für einen bionisch inspirierten Ansatz zur Entwicklung eines speziellen Furnierwerkstoffes.

Spiralförmige Faserverläufe und Verstärkungen sind in der Pflanzenwelt in den verschiedenen Strukturebenen zu finden. Bekannt ist, dass bei Holz die spezifischen Eigenschaften durch den Aufbau effizienter Strukturen optimiert werden. Dies trifft nicht nur auf die Makrostruktur am Beispiel des Drehwuchses bei Baumstämmen zu, sondern beginnt bereits auf submikroskopischer Ebene mit den differenzierten Cellulosemikrofibrillenanordnungen in den einzelnen Zellwandschichten und setzt sich in der Mikrostruktur in Form spiralförmiger Versteifungen dünnwandiger und weitlumiger Holzzellen fort. Ziel derartiger, interdisziplinär ausgelegter Untersuchungen ist es, diese in der Natur beobachteten spiraligen Versteifungen tiefgründig zu analysieren und das in den verschiedenen Strukturebenen beobachtete Prinzip auf sehr stabile, die natürliche Festigkeit des Holzes ausnutzende und mit minimalem Materialeinsatz zu bauende Holzkonstruktionen und andere technische Anwendungen zu übertragen.

Festvortrag zur Öffentlichen Frühjahrssitzung am 13.4.2007

Hans-Joachim Knölker (Dresden), Mitglied der Mathematisch-naturwissenschaftlichen Klasse:

Dr. rer. nat., Professor für Organische Chemie im Department Chemie der Technischen Universität Dresden; am 10. März 2006 zum Ordentlichen Mitglied der Mathematisch-naturwissenschaftlichen Klasse der Sächsischen Akademie der Wissenschaften zu Leipzig gewählt.

Von der Heilpflanze zu neuen Medikamenten – Welche Beiträge kann die organische Synthese leisten?

Die Natur ist seit jeher eine unerschöpfliche Quelle biologisch aktiver Verbindungen, die auch vom Menschen gezielt als Wirkstoffe genutzt werden. In der traditionellen Volksheilkunde wurden Pflanzenextrakte seit Jahrhunderten zur Behandlung von Krankheiten und Linderung körperlicher Gebrechen eingesetzt. Später ging man dazu über, die eigentlichen Wirkstoffe aus diesen Heilpflanzen als Reinsubstanzen zu isolieren, um Nebenwirkungen von Begleitsubstanzen zu vermeiden. Heutzutage werden diese Wirkstoffe häufig durch chemische Synthese hergestellt. In der pharmazeutischen Industrie gewinnen zunehmend synthetische Verbindungen, die nicht in der Natur vorkommen, an Bedeutung. Aber auch in der modernen Wirkstoffsynthese ist für die Entwicklung neuer Medikamente die Natur häufig der Ideengeber, insbesondere wenn es darum geht, neue Strukturprinzipien, sog. „Leitstrukturen”, zu finden. Um neue Beispiele für solche Strukturen zu finden, werden auch Schwämme, Algen oder Mikroorganismen, untersucht.

Auf der Suche nach Leitstrukturen für neue Wirkstoffkandidaten ist man bei den Naturstoffen besonders häufig erfolgreich. Das liegt daran, dass die Naturstoffe aufgrund ihrer biologischen Funktion bereits durch die Evolution „ausgewählte” Strukturen besitzen und deshalb auch bessere Leitstrukturen für die Wirkstoffforschung repräsentieren. Besonders häufig finden sich biologisch hochaktive Verbindungen in der Gruppe der Alkaloide. Das sind stickstoffhaltige Naturstoffe, die sich biogenetisch meistens von den Aminosäuren ableiten. Im Vortrag werden einige Beispiele für pharmakologisch wirksame Alkaloide vorgestellt, die in der Medizin Anwendung finden. In den letzten beiden Jahrzehnten wurde eine Vielzahl pharmakologisch aktiver Carbazol-Alkaloide isoliert, die aus unterschiedlichen natürlichen Quellen in nur üußerst geringen Mengen erhalten wurden. Das geringe Vorkommen dieser Verbindungen in der Natur und ihre strukturellen Besonderheiten erfordern die Entwicklung effizienter Synthesestrategien, um die Naturstoffe sowie ihre synthetischen Analoga hinsichtlich ihrer pharmakologischen Wirkungen eingehend untersuchen zu können. Eine zentrale Rolle spielen dabei sog. „konvergente Synthesen”, in denen Synthesebausteine durch metallorganische Reaktionen zusammengefügt werden. Am Beispiel von Carbazol-Alkaloiden, die eine schwache Aktivität gegen Tuberkelbakterien aufweisen, wird gezeigt, wie man durch einfache Strukturvariation zu erheblich aktiveren Substanzen gelangt, die nun als Leitstrukturen für neue Wirkstoffe angesehen werden können.

Vortrag am 9.3.2007

Jürgen Tomas (Magdeburg), Mitglied der Technikwissenschaftlichen Klasse:

Dr.-Ing. habil., Professor für Mechanische Verfahrenstechnik an der Otto-von-Guericke-Universität Magdeburg; am 10. März 2006 zum Ordentlichen Mitglied der Technikwissenschaftlichen Klasse gewählt.

Forschungsschwerpunkte: Partikeltechnik, Verfahrenstechnik komplexer Stoffkreisläufe, Produkteigenschaften ultrafeiner Partikel – Mikromechanik u. Fließverhalten kohäsiver Pulver

Produkteigenschaften ultrafeiner Partikel

Es gibt nur wenige Zweige einer Volkswirtschaft, in der nicht in irgendeiner Form disperse Feststoffprodukte – Schüttgüter, Pulver – erzeugt, transportiert, umgeschlagen, gelagert, gewandelt, verarbeitet oder verbraucht werden. In der Partikeltechnik (d.h. Verfahrenstechnik, chemische und pharmazeutische Technik, Werkstofftechnik, Lebensmitteltechnik) wird der energiesparenden Erzeugung gezielter physikalisch-chemischer Produkteigenschaften besondere Beachtung geschenkt.

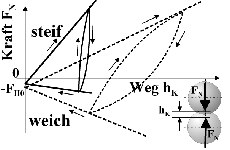

Das umfasst feindisperse Partikel (Größe etwa d < 100 µm), ultrafeine (d < 10 µm) bis nanodisperse (d < 100 nm) Partikel. Neben der hohen spezifischen Oberfläche der nanodispersen Partikel ist die abnehmende Kontaktsteifigkeit mit abnehmender Partikelgröße Ursache für zahlreiche Adhäsionseffekte, die auf der van-der-Waals-Anziehung im unmittelbaren Kontakt beruhen. Mit Hilfe des neuen Modells „steife Partikel mit weichen Kontakten“ wird die elastisch-plastische Repulsion bei Normalbelastung eines glatten Kugelkontaktes erläutert. Die anziehenden van-der-Waals-Kräfte lassen sich mit einem Kugel-Kugel-Modell ohne jegliche Kontaktdeformation und zusätzlich mit einem Platte-Platte-Modell für weiche inelastische Kontakte beschreiben. Solche Kraft-Weg-Gesetze der Kontaktdeformationen bei Belastung, Entlastung, Wiederbelastung und Kontaktablösung zeigt Bild 1.

Bild 1: Kraft-Weg-Diagramm der elastisch-plastischen Kontaktdeformation glatter Kugeln.

Die Flächen zwischen den Be- und Entlastungskurven sind ein Maß für die Energiedissipation im Kontakt, z.B. durch Gitterversetzungen. Aus den Be- und Entlastungskurven werden neue Haftkraft-Normalkraft-Modelle gewonnen, die die momentane mikroskopische Kontaktverfestigung im Sinne eines typischen Stoffgesetzes für kohäsive – makroskopisch gesehen – bindige, haftende, schlecht fließende Pulver beschreiben. Mit dieser lastabhängigen, d.h. von der Belastungsvorgeschichte abhängigen Haftkraft im elastisch-plastischen Kontakt lassen sich die bekannten, mikromechanischen Modelle für elastisches und reibungsbehaftetes Kontaktgleiten, -rollen und -verdrehen (Torsion) deutlich erweitern [1]. Aus den neuen Kraft-Weg- und Moment-Drehwinkel-Gesetzen werden die lastabhängigen Arbeitsbeträge für die Hysterese bei Be-/Entlastung und Kontaktablösung infolge Coulomb-Reibung (Energiedissipation) berechnet. Simulationen der Dynamik des Fließens kohäsiver Pulver mit der sog. Diskreten-Elemente-Methode (DEM) ergänzen den Beitrag.

Mit den physikalisch begründeten Modellen werden die Antwortfunktionen auf unterschiedliche Beanspruchungs- und Fließzustände bei Prozessen der Produktgestaltung sowie bei Lager- und Fördervorgängen beschrieben. 30 Jahre praktische Erfahrungen zeigen, dass sich ultrafeine kohäsive Pulver hinsichtlich ihrer mechanischen Eigenschaften in diese umfassenden Modellvorstellungen ausgezeichnet integrieren lassen.

[1] Tomas, J., Adhesion of ultrafine particles – a micromechanical approach, Chem. Engng. Sci. (2007), doi: 10.1016/j.ces.2006.12.055

Vortrag am 9.3.2007

Andreas Reichenbach (Leipzig), Mitglied der Mathematisch-naturwissenschaftlichen Klasse:

Dr. med. habil., Professor für Neurophysiologie am Paul-Flechsig-Institut für Hirnforschung der Universität Leipzig; am 10. März 2006 zum Ordentlichen Mitglied der Mathematisch-naturwissenschaftlichen Klasse gewählt.

Forschungsschwerpunkte: Neurophysiologie/Sinnesphysiologie, Funktion der Wirbeltiernetzhaut, Rolle der Gliazellen bei Entwicklung, Informationsverarbeitung und Erkrankungen von Netzhaut und Gehirn.

Die Wirbeltiernetzhaut – ein merkwürdiges Sinnesorgan

Im Unterschied zu anderen Sinnesorganen stülpt sich die Wirbeltiernetzhaut aus der embryonalen Anlage des Gehirns aus und ist damit selbst Bestandteil des Zentralnervensystems. Tatsächlich findet in den Nervenzell-Schaltkreisen der Netzhaut bereits eine komplexe Informationsverarbeitung statt, bei der Bildeigenschaften wie Kontraste, Bewegungen oder Farben herausgerechnet und in parallelen „Kanälen” zum Gehirn weitergeleitet werden. Die dafür verantwortlichen Nervenzellschichten liegen wegen der embryonalen Ausstülpungs- und Faltungsvorgänge auf der „vorderen” Seite der Netzhaut, also zwischen dem ins Auge einfallenden Licht und den lichtempfindlichen Sinneszellen. Zudem müssen die Netzhäute verschiedener Wirbeltiere sehr verschiedene Aufgaben erfüllen: Raubtiere müssen Lokalisation und Abstand ihrer Beute exakt erkennen, potentielle Beutetiere benötigen eine Rundumsicht auf ihre Umgebung; nachtaktive Tiere müssen geringste Lichtintensitäten wahrnehmen können, tagaktive Tiere profitieren von Kontrast- und Farbwahrnehmung. Die strukturelle und funktionelle Optimierung der Wirbeltiernetzhaut in Hinblick auf diese diversen, teilweise widersprüchlichen Anforderungen ist noch immer Gegenstand der Forschung.

Schon lange bekannt ist die Ausstattung der Netzhaut mit zwei Typen von Lichtsinneszellen (Zapfen und Stäbchen) und jeweils dazugehörigen Nervenzellschaltkreisen. Ausgehend von einer „universell nutzbaren, prototypischen Wirbeltiernetzhaut” mit etwa gleich vielen Stäbchen und Zapfen haben sich zwei divergente Spezialisierungen entwickelt. Auf der einen Seite ist das die photopisch spezialisierte Netzhaut (-region); sie dient dem Sehen bei Tageslicht und vermittelt ein detail- und kontrastreiches farbiges Bild der Umwelt, ist jedoch unter Dämmerungsbedingungen blind. Ein Beispiel dafür ist die Fovea centralis (= Netzhautmitte) des Menschen; sie enthält keine Stäbchen, dafür aber dicht gepackte Zapfen, von denen jeder seine Signale über mehrere „private” Schaltzellen weitergibt. Auf der anderen Seite ist es die skotopisch spezialisierte Retina; diese ist extrem lichtempfindlich und erlaubt das Sehen in dunkler Umgebung, kann aber weder Details noch Farben auflösen (und ist bei Tage „überbelichtet” und daher blind). Eine solche Retina findet sich bei Tiefseefischen, aber auch bei nachtaktiven Säugern wie z.B. beim Dachs; sie enthält überwiegend oder ausschließlich Stäbchen, von denen jeweils mehr als 1000 ihre Signale auf eine gemeinsame Schaltzelle zusammenfließen lassen. Dazu gehört eine lichtreflektierende Schicht („Tapetum lucidum”) hinter der Retina, um nicht absorbierte Lichtquanten erneut den Sinneszellen zuzuführen. Die Netzhäute vieler Wirbeltiere einschließlich des Menschen stellen einen Kompromiß dar: Der zentrale Bereich enthält vermehrt Zapfen, der periphere ist stäbchendominiert.

Bei verschiedenen Fischen kommt ein weiterer, noch nicht verstandener Netzhauttyp vor: Die ‘gruppierte Netzhaut’ ist dadurch charakterisiert, daß Hunderte von Stäbchen mit Dutzenden von Zapfen in Bündeln zusammengefaßt sind, die jeweils von einer becherartigen lichtreflektierenden Zellstruktur wie von einem Parabolspiegel umgeben werden. Da alle Sinneszellen einer Gruppe dem gleichen Lichtreiz exponiert werden, muß die räumliche Auflösung der visuellen Information außerordentlich grob sein. Andererseits liegen die lichtsensitiven Segmente der Stäbchen hinter dem „Parabolspiegel” und erhalten daher nur einen geringen Teil des einfallenden Lichtes. Offenbar ist die ‘gruppierte Netzhaut’ weder für das Kontrastsehen noch für die Wahrnehmung schwacher Lichtreize optimiert. Zur Zeit wird untersucht, ob mit dieser Struktur „absichtlich” unwichtige Bild-Details ausgefiltert werden sollen, da die Tiere in trüben Gewässern leben und ihr Gehirn vermutlich die nötige Bildfilterung nicht bewältigen kann. Ein solches Prinzip könnte auch für technische Anwendungen interessant sein.

Schließlich wird eine Lösung für das eingangs erwähnte grundsätzliche Problem der „invertierten” Wirbeltiernetzhaut vorgestellt: Die unvermeidliche Streuung beim Durchtritt des Lichtes durch die den Sinneszellen vorgelagerten Nervenzellschichten sollte zu schwerwiegenden Verlusten in Intensität und Qualität der Abbildung führen. Es kann jedoch gezeigt werden, daß säulenförmige Gliazellen, die in regelmäßiger Anordnung diese Nervenzellschichten durchziehen, ähnlich wie die Glasfasern einer optischen Faserplatte die Abbildung punktgetreu und verlustarm zu den Sinneszellen übertragen. Die Evolution hat hier vor Jahrmillionen ein optisches Prinzip etabliert, das vor wenigen Jahren als Errungenschaft unserer modernen Technologie gefeiert wurde – eines von vielen Beispielen dafür, daß die Wirbeltiernetzhaut nicht nur ein merkwürdiges, sondern vor allem ein funktionell perfektioniertes Sinnesorgan ist.

Vortrag am 9.2.2007

Heiner Kaden (Meinsberg), Mitglied der Mathematisch-naturwissenschaftlichen Klasse:

Dr. rer. nat. habil., Honorarprofessor i. R. an der Technischen Universität Bergakademie Freiberg, ehem. Direktor bzw. stellvertr. Direktor des Kurt-Schwabe-Instituts für Mess- und Sensortechnik e.V. Meinsberg. Ordentliches Mitglied der Akademie (seit 1991). Mitglied der Kommission für Umweltprobleme (seit 1996), Mitglied der Kommission für Wissenschaftsgeschichte (seit 1992, Vorsitzender der Kommission seit 1998).

Arbeitsgebiet: Elektrochemie, Sensorik.

Deutsch-Russische und Deutsch-Baltische Beziehungen – ein Beitrag zur Geschichte der Sächsischen Akademie der Wissenschaften zu Leipzig

Ziel des Vortrages ist die Darstellung und Bewertung Deutsch-Russischer Beziehungen der Sächsischen Akademie der Wissenschaften zu Leipzig (SAW) seit ihrer Gründung bis zur Gegenwart. Das Baltikum, dessen Staaten eine wechselvolle Geschichte der Selbständigkeit und der Zugehörigkeit zu Russland und zur UdSSR durchlebt haben, ist im Titel eigens ausgewiesen.

Internationalität wird seit dem 18. Jh. als eines der prägenden Charakteristika von Wissenschaftsakademien angesehen. Die deutschen Wissenschaftsakademien haben, besonders seit dem 19. Jh., sehr intensive Beziehungen zur russischen Wissenschaft gehabt. Das Verhältnis einer zu gründenden Sächsischen Akademie zu Russland spielte bereits in den Überlegungen von G. W. Leibniz (1646–1716) etwa 150 Jahre vor dem Gründungsjahr eine Rolle. Im ersten Teil des Vortrages wird kurz auf drei vor der SAW gegründete Akademien (München, Göttingen, Berlin) eingegangen. Ihre Beziehungen zur Russischen Akademie der Wissenschaften waren eng; sie sind in Publikationen und auch in bedeutenden Veranstaltungen gewürdigt worden. Für die SAW besteht in dieser Hinsicht ein Desiderat. Außer dem Verzeichnis der Mitgliedschaft russischer/baltischer korrespondierender Akademiemitglieder in den Jahrbüchern der SAW enthalten Veröffentlichungen zur Geschichte der SAW nur vereinzelt Hinweise auf die wissenschaftlichen Kontakte zu Russland und dem Baltikum. Die Wahl korrespondierender Mitglieder (KM) ist im Allgemeinen das Resultat individueller wissenschaftlicher Kontakte der Akademiemitglieder, die letztlich Vorschlag und Wahl von KM zur Folge haben. Andererseits ist die Wahl deutscher Gelehrter in ausländische Akademien, so in die St. Petersburger Akademie, das Zeichen hoher Anerkennung ihres wissenschaftlichen Renommees. Die Analyse der gegenseitigen Mitgliedschaften weist für die SAW auf zwei Perioden hin, in denen übergeordnete Maßstäbe und Interessen die Wahl von KM in die St. Petersburger/Moskauer Akademie sowie in die SAW beeinflusst haben. Im 19. Jh. ist die Zuwahl deutscher Gelehrter in die Russische Akademie der Wissenschaften auf die generelle, weltweite Anerkennung der deutschen Wissenschaft zurückzuführen. Nach 1945 hat die Wahl russischer KM offenbar zur Bewahrung von Existenz und Unabhängigkeit der SAW beigetragen.

Wirken und Einfluss einiger Mitglieder (C. G. Carus, W. Stieda, Th. Frings, V. M. Žirmunskij, K. Schwabe, A. N. Frumkin, V. I. Spitcyn, J. Stradiņš) der zwei betrachteten Akademien auf die wechselseitigen Beziehungen werden vorgestellt, dies unabhängig davon, ob die Wahl in die Akademien vor oder nach den für die Kooperation mit Russland bzw. der UdSSR relevanten Zeiten stattgefunden hat. Über Ursache und Umstände für die Nichtanerkennung der Wahl eines KM aus Lettland im Jahr 1976 kann jetzt erstmals eine Aussage getroffen werden. Weiter wird die Tätigkeit sog. (deutscher) „Spezialisten”, die nach 1945 in der SU gearbeitet haben (darunter seitens der SAW die späteren Mitglieder G. Hertz, P. Görlich, G. E. R. Schulze) gestreift. Schließlich wird ein Blick auf die Internationalität der SAW, gemessen an der Zahl ihrer KM, geworfen.

Vortrag am 9.2.2007

Gerhard Kaiser (Freiburg i. Br.), Mitglied der Philologisch-historischen Klasse:

Der Referent, geboren 1927 in Tannroda bei Weimar, promoviert in Geschichte an der Universität München, habilitiert als Literaturwissenschaftler in Mainz, seit 1963 Ordinarius für neuere deutsche Literaturgeschichte in Saarbrücken und Freiburg i. Br., seit 1990 im Ruhestand, Ehrendoktor der Philosophischen Fakultät der Universität Lüttich und der Evangelisch-theologischen Fakultät der Universität Tübingen, Träger einer goldenen Medaille der Internationalen Goethe-Gesellschaft in Weimar, im Wintersemester 2004/05 Gastprofessor der Theologischen Fakultät der Universität Basel, erforscht in den letzten Jahren literarische Strukturen der Bibel unter theologischer Fragestellung, z.B. in einer vor der Veröffentlichung stehenden Monographie mit der These, daß der letzte theologische Horizont des Buches Hiob aus der Kombination von Erzählrahmen aus olymian view-point, dramatisch-dialogischem Mittelteil und deus-ex-machina-Offenbarung Gottes hervorgeht.

Väter und Brüder. Weltordnung und gesellschaftlich-politische Ordnung in Schillers Werk (Wegen Krankheit ausgefallener Vortrag vom 10.2.2006)

Vater-und-Sohn-Konstellationen und Brüder-Konstellationen stehen durchgehend in Schillers Werk zeichenhaft für die Welt- und Gesellschaftsordnung und ihre Krise. In den „Räubern”, dem dramatischen Erstling, ist der Vater-Sohn-Konflikt, verschlungen mit dem Bruderkonflikt – beide tödlich verlaufend – der Index für die vorrevolutionäre Zerrüttung der Metaphysik, der patriarchalischen Familienordnung und des absoluten Staats. Noch in „Wilhelm Tell”, dem letzten vollendeten Drama Schillers, ist die Nötigung eines Vaters, durch einen Schuß das Leben des eigenen Sohns aufs Spiel zu setzen, Inbegriff der Weltverkehrung und Motiv des Tyrannenmords – der Tyrann immer wieder bei Schiller Zerrbild des Vaters. Innerhalb dieses Symbol-Systems findet nun bei Schiller ein tiefgreifender Wandel statt: Erstens wird die metaphysische Gründung der Vater- und Brüderordnung zur anthropologisch-geschichtsphilosophischen: In den „Räubern” repräsentiert Graf Moor eine metaphysische Vaterordnung der Welt. Wilhelm Tell repräsentiert als Familienvater eine naturhafte Kultur ursprünglicher Menschen, die über alle Konflikte der geschichtlichen Welt auf einen Harmoniezustand der Gesellschaft am Ziel der Geschichte verweist.

Zweitens tritt seit „Fiesco” und „Don Karlos” vor die Folie der Vaterordnung das Ideal einer Brüderordnung freier Menschen, die Schillers Entsprechung zur Parole der Französischen Revolution von Freiheit, Gleichheit und Brüderlichkeit ist.

Der Referent plädiert mit diesem Deutungsmodell für eine Literaturwissenschaft, welche die Verinselung der sog. werkimmanenten Interpretation ebenso vermeidet wie die Zerfaserung der Werke in biographische und historische Bezüge und stattdessen die Entfaltung einer durchgehenden symbolischen Werkstruktur in individuellen Varianten ins Auge fasst.

Vortrag am 12.1.2007

Reiner Groß (Kreischa), Mitglied der Philologisch-historischen Klasse:

Dr. phil., Professor i. R. für Regionalgeschichte Sachsens an der Universität Leipzig, am 3. Juni 1988 zum Ordentlichen Mitglied der Philologisch-historischen Klasse gewählt.

Hautptarbeitsgebiete: Landesgeschichte Sachsens, Regionalgeschichte.

200 Jahre Königreich Sachsen – Erinnerung an ein bedeutsames Ereignis in der sächsischen Landesgeschichte

Das Jahr 1806 brachte für die zu dieser Zeit Lebenden einen tiefen Einschnitt in ihr Dasein. Europa befand sich in einer alle Bereiche des Lebens erfassenden Umbruchsphase. Das napoleonische Kaiserreich Frankreich hatte begonnen, die europäische Staatenwelt in seinem Sinn neuzuordnen. Das 1000-jährige Heilige Römische Reich Deutscher Nation hörte auf zu existieren. Neue staatliche Gebilde entstanden, Millionen Menschen erhielten ein neues Staatsoberhaupt, in der deutschen Staatenwelt vollzogen sich gravierende Änderungen. In diesen europäisch dominierten Entwicklungsprozess ist das albertinische Kurfürstentum Sachsen voll eingebunden. Darum soll im Vortrag an den Sinn der Bewahrung und Pflege sächsischer Landesgeschichte erinnert werden. Am 20. Dezember 1806 wurde in der kursächsischen Residenz Dresden an sieben Plätzen öffentlich bekannt gemacht, dass Kurfürst Friedrich August III. die Würde des Königs von Sachsen angenommen habe. Damit wurde aus dem Kurfürstentum Sachsen das Königreich Sachsen, aus Kurfürst Friedrich August III. der König Friedrich August II. Dieses Ereignis stand am Ende eines langen politischen und verfassungsrechtlichen Weges und war zugleich Beginn einer neuen Phase gesellschaftlicher Entwicklung in Sachsen. Diese mehrere Jahrzehnte umfassende Entwicklung hat drei Betrachtungsebenen: eine europäische, eine deutsche und eine sächsische Ebene, die ineinander verwoben sind und sich gegenseitig beeinflussten.

Die Vorgeschichte dieser Entwicklung beginnt bei näherer Betrachtung mit dem Hubertusburger Frieden 1763 und reicht in ihren Folgen bis 1831. Wichtige Etappen für Kursachsen sind dabei die Jahre 1790/91, 1997/98, 1802/03, 1813 und 1815. Es wird versucht, die Grundlinien dieser Entwicklung und die Auswirkungen für Sachsen zu verdeutlichen.

Vortrag am 12.1.2007

Ulrich Förstner (Hamburg-Haburg), Mitglied der Technikwissenschaftlichen Klasse:

Dr. rer. nat., Professor für Umweltschutztechnik an der Technischen Universität Hamburg-Harburg, am 10. März 2000 zum Korrespondierenden Mitglied der Technikwissenschaftlichen Klasse gewählt.

Hauptarbeitsgebiete: Schadstoffanalytik, Umweltschutztechnik, Sedimentgeochemie, Langzeitstrategien kontaminierter Böden und Sedimente.

Schadstoffbelastung der Elbsedimente – Risiken, Trends, Lösungsansätze

Trotz Rückgang der Schadstoffeinleitungen sind vielerorts Flusssedimente noch stark verschmutzt und stellen damit eine langanhaltende Belastung für die Gewässerqualität im Einzugsgebiet bis in die Küstenregionen dar. Die Verschmutzungen stammen aus diffusen Lufteinträgen und Einleitungen von Abwässern, z.B. auch bei der Flutung von Bergwerken, und aus früherer Industrieproduktion. In der Elbe werden schon bei mittleren Hochwässern kontaminierte Feststoffe aus dem Bitterfelder Chemierevier bis in den Hamburger Hafen verfrachtet, markiert durch ein typisches Dioxinmuster aus der früheren Metallproduktion. Bei der Risikobewertung der kritischer Teilbereiche („Areas of Concern”) eines Flusseinzugsgebiets im Hinblick auf die Sedimentqualität in den großen Flusshäfen im Unterlauf bedarf es der Abschätzung von Resuspension und Transport kontaminierten Materials bei unterschiedlichen hydrologischen Bedingungen. Daten, die zu dieser Abschätzung benötigt werden, umfassen (i) Resuspendierungsmessungen sedimentierten Materials (z.B. aus Buhnengebieten), (ii) Messungen der Schadstoffbelastung von Schwebstoffen, (iii) Schwebstofffrachten, (iv) Sedimentkontaminationen nach Flutereignissen sowie (v) Untersuchungen zu Sedimentations- und Resuspensionsgebieten („Senken” und “Quellen”).

In einer Studie zur Belastung der Elbesedimente mit Schadstoffen vom November 2005 (TU Hamburg-Harburg, Bundesanstalt für Gewässerkunde Koblenz und Fa. ELANA Falkenberg, im Auftrag der Hamburg Port Authority [früher „Strom- und Hafenbau”]) konnten mit wenigen Ausnahmen allen „Areas of Concern” teilweise historische Quellen zugeordnet werden. Die verwendeten Schwebstoff- und Sedimentdaten für das Elbeeinzugsgebiet stammten aus regulären Messprogrammen der ARGE Elbe und IKSE, aus Messprogrammen der Bundesanstalt für Gewässerkunde zum Sedimentkataster und zum Schwebstoffhaushalt der Bundeswasserstraßen sowie aus verschiedenen Forschungsprojekten des BMBF-Verbundvorhabens „Elbe Schadstoffforschung”. Zu den wichtigsten Beiträgen zur Sedimentthematik im Elbeeinzugsgebiet zählen die Arbeiten der SAW-Forschergruppe, z.B. zur Hintergrundbelastung von Schwermetallen, zur Funktion des Bitterfelder Muldestausees als Schadstoffsenke und die maßgebliche Studie über die Verlagerung, Verdünnung und Austrag von schwermetallhaltigen Feststoffen aus der Saale, dem größten Nebenfluss der mittleren Elbe.

Die bisher bei kontaminierten Gewässersedimenten eingesetzten Techniken wiesen gravierende Nachteile auf; insbesondere kommt eine Reinigung, z.B. durch chemische Extraktion oder biologischen Abbau von Schadstoffen, wegen der Heterogenität der Schadstoffmixturen nur in Ausnahmefällen in Frage. Dagegen stellt das inzwischen vertiefte Prozessverständnis des „Natural Attenuation”-Ansatzes für alle Behandlungs- und Überwachungsstrategien für kontaminierte Grundwässer, Böden und auch Sedimente ein beträchtliches wirtschaftliches Potenzial dar. Eine besonders gut geeignete Region für ein übergreifendes Projekt ist das Niederungsgebiet Spittelwasser im Abstrom des Bitterfelder Chemiereviers mit seinen teilweise hochbelasteten Auenböden und -sedimenten: Hier wurde anlässlich der Konferenz ConSoil 2000 ein internationaler Fallstudienvergleich durchgeführt, beim dem eine Fülle offener Fragen identifiziert wurden, die z.Zt. in einem Verbundprojekt des BMBF bearbeitet werden.