Versprechen in der Wissenschaft

Diskussion der Kommission Wissenschaft und Werte im Rahmen der Öffentlichen Herbstsitzung am 11.12.2015

Vortrag am 11.12.2015

Hannes Siegrist, Ordentliches Mitglied der Philologisch-historischen Klasse.

Vorsitzender der Kommission Wissenschaft und Werte der Sächsischen Akademie der Wissenschaften zu Leipzig, Professor für vergleichende Kultur- und Gesellschaftsgeschichte des modernen Europa an der Universität Leipzig, Ordentliches Mitglied der Philologisch-historischen Klasse seit 9. Februar 2007.

Statements:

Einleitung

Die interdisziplinäre Kommission „Wissenschaft und Werte“ der Sächsischen Akademie der Wissenschaften behandelt zurzeit Grundfragen der Wissenschaftsethik anhand der Problematik des Versprechens in der Wissenschaft. Wir untersuchen Inhalte, Formen, Funktionen und Folgen von Versprechen, die von Wissenschaftlern (aber auch von Dritten im Namen der Wissenschaft) gegeben werden. Damit leisten wir einen kritischen und weiterführenden Beitrag zur Frage, wodurch das Handeln der Akteure des wissenschaftlichen Feldes motiviert und reguliert wird.

Versprechen sind Aussagen, womit der Versprechende sich gegenüber Dritten und sich selbst auf bestimmte Absichten und Ziele festlegt. Das Versprechen bindet den Versprechenden und bestimmt die Erwartungen und Ansprüche derjenigen, denen es gegeben wird (Selbst- und Fremdbindung). Es handelt sich um eine kommunikative Strategie und um eine sozio-kulturelle Institution (Regel, Spielregel), die das Handeln von Individuen, Organisationen und Gruppen motiviert und zugleich koordiniert. Versprechen sorgen in dynamischen Gesellschaften sowohl für Erwartungssicherheit als auch für eine gewisse Flexibilität in den Kooperations- und Wettbewerbsbeziehungen.

Wir können Wissenschaft als ein kohärentes oder kanonisiertes System von Aussagen, als ein hochgradig reguliertes und zweckrational organisiertes soziales Feld, oder als wettbewerbsförmigen und ergebnisoffenen Prozess betrachten. Versprechen erfüllen dabei besondere Funktionen: Sie stellen die Kooperation und Anerkennung von Wissenschaftlern und Wissensorganisationen auf Dauer. Sie ermöglichen eine gewisse Flexibilisierung und Dynamisierung des Handelns in wissenschaftlichen Grenzbereichen und neuen Feldern. Und sie regeln die Zusammenarbeit zwischen der Wissenschaft und anderen Funktionssystemen wie Politik, Wirtschaft, Kultur und Recht. Die Analyse impliziter und expliziter Versprechen, die von Wissenschaftlern oder im Namen der Wissenschaft gegeben und wodurch interne und externe Kommunikations- und Kooperationsbeziehungen der Wissenschaft gesteuert werden, dient dazu, soziale und symbolische Strategien von Individuen, Organisationen und Systemen einer kritischen Bewertung zu unterziehen. Sie verbindet das spezielle Interesse für Fragen der Stabilität und des Wandels ethischer und professioneller Verhaltensstandards mit dem allgemeinen Interesse für Probleme des wissenschaftlichen, kulturellen, medialen, technischen, wirtschaftlichen, politischen und rechtlichen Wandels. Die Abgrenzung und Durchlässigkeit der Wissenschaft im engeren Sinn bzw. deren Verhältnis zu anderen Funktionssystemen lässt sich etwa anhand der Unterscheidung zwischen wissenschaftlichen Standardversprechen, situativen Zusatzversprechen und spekulativen Versprechen diskutieren.

Die Ausgangsthese lautet: In der globalisierten Wissens- und Informationsgesellschaft führen der Wettbewerb um forschungsrelevante Ressourcen, die Konflikte über die politische Kontrolle und wirtschaftliche Verwertung von Grundlagen- und Anwendungswissen, der Wettbewerb um Position und Status sowie Spannungen wegen des ungleichen Zugangs zu wissenschaftsbasierten Konsumgütern und Dienstleistungen dazu, dass im Namen der Wissenschaft immer mehr versprochen wird. An dem Überbietungswettbewerb beteiligen sich nicht nur Vertreter einzelner Wissenschaftsrichtungen, sondern auch Repräsentanten der Wirtschaft, Politik, Kultur, Öffentlichkeit und Zivilgesellschaft. Während die symbolische und soziale Praxis des wissenschaftsbasierten Versprechens, Ankündigens, Prognostizierens, Verheißens und Spekulierens ausufert, hinkt die Entwicklung von Kriterien und Regeln für das Geben, die Umsetzung und die (positive oder negative) Sanktionierung solcher Versprechen oftmals hinterher.

Vortrag am 11.12.2015

Uwe-Frithjof Haustein, Ordentliches Mitglied der Mathematisch-naturwissenschaftlichen Klasse.

Professor i.R. für Dermato-Venerologie an der Universität Leipzig, Ordentliches Mitglied der Mathematisch-naturwissenschaftlichen Klasse seit 3. Juni 1988.

Versprechen und Verantwortung und Vertrauen in der Medizin

Jeder Arzt ist in zweierlei Hinsicht mit dem Versprechen befasst: Erstens auf der Grundlage von mehr oder weniger wissenschaftlich gesicherten Erkenntnissen für den weiteren Fortgang von Diagnostik und Therapie (pragmatisch) und zweitens im Sinne von „Zuspruch“, um den Patienten in vermeintlich hoffnungslosen Situationen zu trösten und ihnen Mut zu machen (situativ, spekulativ), immer aber unter der Voraussetzung, verantwortungsvoll zu handeln und Vertrauen auszustrahlen – ein schwieriger Spagat. Wichtig sind auch allgemeingültige Grundsätze der Versprechen seitens der Wissenschaftsdisziplin Medizin – Erstens (exemplarisch) – im Rahmen von Forschungsanträgen im Wettbewerb um forschungsrelevante Ressourcen zur Lösung von speziellen Fragestellungen sowieZweitens (systematisch) – die allgemeinen gesellschaftsrelevanten Versprechen zwecks prinzipieller Verbesserungen gesundheitlicher Probleme wie Lebensverlängerung, Anti-Aging, Eradikation von Krankheiten, Vermeidung von Infektionen (Tbc, AIDS, Ebola) oder auch die Optimierung sozialmedizinischer Gegebenheiten wie beispielsweise innerhalb der geriatrischen Betreuung, insbesondere Depression und Demenz (Alzheimer, Parkinson) sowie Krebsbekämpfung und Transplantation von Stammzellen (Organersatz). Die Gefahr des Spekulativen oder Verantwortungslosen ist hier groß, insbesondere, wenn die Versprechen nicht genug fundiert abgegeben werden, wobei die Fragen von Glaubwürdigkeit, Haftung, Verführung und eben Verantwortungslosigkeit ins Spiel kommen.

Falsche und vollmundige Versprechen bedeuten eine Gefahr, auch in Hinblick des Paradigmenwechsels von der heilenden zur individualisierten/personalisierten (Präzisions-) Medizin (Rolle der Pharmaindustrie!).

Zur Verbesserung der Strategien im Arzt-Patient-Verhältnis wurde in letzter Zeit vieles erforscht. Der interdisziplinäre Diskurs ist notwendig und hält an. Sicher ist das deliberative (überlegende, beratschlagende) Arzt-Patient-Beziehungsmodell zu favorisieren, das genügend Spielraum für Patientenautonomie, Mitspracherecht, gemeinsame Verantwortung in flexibler, konsensueller, empathischer Gestaltung unter Berücksichtigung eines ganzheitlichen Krankheitsverständnisses zulässt.

Das ärztliche Berufethos unterliegt noch immer dem hippokratischen „Salus aegroti suprema lex“ – das Wohl des Kranken ist höchstes Gesetz. Aus heutiger Medizinethik muss es eigentlich lauten „Salus ex voluntate aegroti suprema lex“, das sich aus dem Willen des Patienten ergibt.

Die zahlreichen anspruchsvollen Versprechen reflektieren alle die hohe Verantwortung des ärztlichen Berufes und seiner Berufung.

Wir treten für eine humane Gesundheitspolitik und ärztlich-ethisch gesteuerte Medizin ein, die den Arzt als Helfer, Heiler, Begleiter und Anwalt des Patienten sieht und dessen Heilungschancen höher bewertet als starre Verwaltungsvorgaben. Diese Versprechen müssen täglich neu erarbeitet und belegt werden, um der geforderten Übernahme von Verantwortung und Bildung von Vertrauen gerecht zu werden.

Vortrag am 11.12.2015

Prof. Dr. Peter Kunzmann Professor für angewandte Ethik in der Tiermedizin an der Tierärztlichen Hochschule Hannover.

Die Ambivalenz von Versprechen in der „Grünen Gentechnik“

Wissenschaftler, die sich mit Pflanzenbiotechnologie befassen, sind mit ihren Versprechen (z.B. Bekämpfung des Hungers) viel vorsichtiger, als NGOs es ihnen andichten.

Allerdings stellen solche Versprechen für die Wissenschaft auch ein hohes Risiko dar: Die große Potenz der Gentechnik wirkt nämlich für viele Zeitgenossen wie eine Bedrohung. Ihre technische Nutzung, politisch ausdrücklich gewollt, rückt die Wissenschaftler leicht in die Komplizenschaft mit den Konzernen. Dieses Image wiederum gefährdet die wichtigste Rolle von Wissenschaftlern im gesellschaftliche Streit: die des unabhängigen Gutachters.

Vortrag am 11.12.2015

Heinz Thoma, Ordentliches Mitglied der Philologisch-historischen Klasse.

Professor für Romanische Literaturwissenschaft und Kulturwissenschaft an der Martin-Luther-Universität Halle-Wittenberg, Ordentliches Mitglied der Philologisch-historischen Klasse seit 14. Februar 1997.

Diagnose statt Versprechen: die Aufgaben der Literatur und Kulturwissenschaften

Die Spezifik der Literatur- und Kulturwissenschaften liegt in ihrer Diagnosefähigkeit von Literatur und Kultur im Hinblick auf die mentalen und kulturellen Sollbruchstellen unserer Gesellschaft. Ihr Gegenstand wandelt sich in der Funktion von Aufklärung (Lehrhaftigkeit, Moral) zur kritischen Autonomie (Realismus) und zur Opposition bzw. Revolte (Bohème, Avantgarden). In der Postmoderne neigt er zum Spiel, wo er sich auf die Welt einlässt, dominiert als Epochenzeichen die Depression. Die Literaturwissenschaften sind zunächst im 19. Jahrhundert als Begründer der jeweiligen Nationalliteraturen gefragt. Ihre eigentliche Modernisierungsqualität erreichen sie erst mit dem Strukturalismus und der beginnenden Aufhebung der strikten Grenzen von Höhenkamm und Pop-art. Als nunmehrige Kulturwissenschaften erreichen sie einen hohen Grad an Reflexivität, Präzision und Verfeinerung, sind damit weniger Kompensationswissenschaften (Odo Marquard) als vielmehr Seismographen und Diagnostiker der moralisch-ästhetischen Verfasstheit der bürgerlichen Formation.

Vortrag am 11.12.2015

Hannes Siegrist, Ordentliches Mitglied der Philologisch-historischen Klasse.

Vorsitzender der Kommission Wissenschaft und Werte der Sächsischen Akademie der Wissenschaften zu Leipzig, Professor für vergleichende Kultur- und Gesellschaftsgeschichte des modernen Europa an der Universität Leipzig, Ordentliches Mitglied der Philologisch-historischen Klasse seit 9. Februar 2007.

Versprechen in den Geschichts- und Sozialwissenschaften

Der Aufstieg der Geschichtswissenschaften und Sozialwissenschaften verbindet sich ursprünglich mit deren Versprechens, Orientierungs-, Ordnungs-, Planungs- und Reflexionswissen für den Übergang von der Vergangenheit zur Gegenwart und von der Gegenwart zur Zukunft bereitzustellen. Der Beitrag behandelt die Verwissenschaftlichung des Sozialen und die Vergesellschaftung der Geistes- und Sozialwissenschaften im Kontext von Nationalisierung und Globalisierung. Er diskutiert das Verhältnis zwischen Standardversprechen, situativen Zusatzversprechen und spekulativen Großversprechen in den Geschichtswissenschaften und Sozialwissenschaften, die im Laufe ihrer Entwicklung zwischen dem Geben von Heilsversprechen und pragmatischer Reflexion schwanken.

Vortrag am 13.11.2015

Hans-Joachim Solms (Halle), Ordentliches Mitglied der philologisch-historischen Klasse

Professor für Geschichte der Deutschen Sprache und älteren Deutschen Literatur, Direktor des An-Instituts „Deutsche Sprache und Kultur“ an der Martin-Luther-Universität Halle-Wittenberg; Ordentliches Mitglied der Philologisch-historischen Klasse seit 8. Februar 2008;

Forschungsschwerpunkte: Historische Grammatik (Mittelhochdeutsch, Frühneuhochdeutsch), Historische Lexikographie, Mundartlexikographie (Frühneuhochdeutsches Wörterbuch, Mittelelbisches Wörterbuch), Sprachgeschichte des Deutschen, Edition spätmittelalterlicher / frühneuzeitlicher Handschriften.

Sprache und Nation

Schon 1936 hatte der Romanist Karl Voßler die Frage nach dem Verhältnis von ‘Sprache und Nation’ als eine in jedem Zeitalter aufgeworfene und aufzuwerfende bezeichnet und damit deutlich gemacht, dass diese Frage den Kern identitär-nationalstaatlichen Selbstverständnisses (Jürgen Osterhammel) berührt und damit auch die Genese national-identitärer Selbstzuschreibungen hinterfragt. Eine abschließende Antwort, so machte Voßler klar, könne es nicht geben, weil die Antworten vor dem Hintergrund der je spezifischen Situation jedesmal anders seien; es handelt sich, so auch Konrad Ehlich, um ‘Konzepte in Veränderung’. Gleichwohl setzt jeder Versuch einer Antwort, setzt auch das Urteil über eine gegebene Antwort die Kenntnis der historischen Genese des Verhältnisses voraus. Diese herauszuarbeiten scheint besonders angesichts der aktuellen politischen Entwicklung notwendig, die das Verhältnis einerseits populistisch vereinfachend instrumentalisiert, es andererseits und in Reaktion darauf aber unbeachtet lässt und damit Chancen vertut.

Der Zusammenhang von ‘Sprache und Nation’ weist hinsichtlich einer dann auch politisch und gesellschaftlich ‘wirksam werdenden Haltung’ weitgehend nur bis in das 19. Jahrhundert und zielt auf den Versuch, ‘klare Kriterien der Zugehörigkeit zum Großkollektiv (Nation) zu formulieren’ (Jürgen Osterhammel). Doch gehen dieser noch jungen voluntativen Entwicklung ältere und bis ins 16. Jahrhundert reichende Bemühungen voraus, die in ihrem Ergebnis zu einer sich herausbildenden Nationalkultur beitrugen (Peter von Polenz). Dabei handelt es sich wesentlich um jene an verschiedenen Orten Europas gegründeten Sozietäten, die sich der Aufgabe widmeten, die jeweils eigene Sprache zu pflegen, zu fördern, zu verbessern: In Paris die Académie francaise, in Florenz die Accademia della crusca, in Köthen die Fruchtbringende Gesellschaft. Deren jeweiliges Wirken trug mit dazu bei, dass das Verhältnis von Sprache und Nation im Verlauf des 19. Jahrhunderts zu einem bewusst reflektierten werden konnte, über welches man dann - vermittelt über das Bewusstsein nationaler Identität – die politisch-nationalstaatliche Entwicklung mit zu gestalten versuchte. Jacob Grimms berühmte und letztlich zum Handeln auffordernde Frage, was ‘wir denn anderes haben, als unsere Sprache und Literatur’, ist nur eine von vielen zeitgenössischen Äußerungen, die die diesbezügliche Bedeutung besonders auch der Sprache erweist.

Fraglich ist, wie sehr sich dies im allgemeinen Bewusstsein niedersetzte und auch Teil des alltäglichen Diskurses wurde. Dies wird anhand der Presse der zweiten Hälfte des 19. Jahrhunderts nachvollziehen. Dabei wird der Blick buchstäblich an den Rand der nationalstaatlichen Entwicklung Deutschlands auf das Großherzogtums Luxemburg gerichtet. Auch für dieses war und ist bis nahezu in die Gegenwart hinein die Frage nach dem Verhältnis von Sprache und Nation zentral.

Im Spiegel der Berichterstattung und Kommentierung der 1848 gegründeten und bis heute existierenden größten Tageszeitung Luxemburgs, dem Luxemburger Wort, kann im Zeitraum 1848 bis 1900 der Prozess der beginnenden Verdrängung eines deutschen und der langsamen Herausbildung eines an die indigene Sprache gebundenen luxemburgischen Selbst- und Nationalbewusstseins herausgearbeitet werden.

Dass diese eine nicht nur historische, sondern eine auch gegenwärtige Realität beschreibt, zeigt sich vor dem Hintergrund der heutigen funktionalen Mehrsprachigkeit Luxemburgs, in der die Sprachbindung ihre unterschiedlichen ‘Voreinstellungen und Wertzuschreibungen’ nicht verloren hat (Heinz Sieburg).

Sie zeigt aber auch – und dies mag ein Beispiel abgeben –, dass vor dem Hintergrund der unhinterfragten Gültigkeit und öffentlichen Anerkennung solcher Wertzuschreibungen massenhafte Integration möglich ist.

Vortrag am 13.11.2015

Jens Haueisen (Ilmenau), Ordentliches Mitglied der Technikwissenschaftlichen Klasse

Professor für Biomedizinische Technik an der TU Ilmenau; Ordentliches Mitglied der Technikwissenschaftlichen Klasse seit 14. Februar 2014;

Forschungsinteressen: Aktive und passive bioelektrische und biomagnetische Phänomene (Messung und Analyse bioelektrischer und biomagnetischer Daten; Numerische Berechnung bioelektrischer und biomagnetischer Felder; Inverse Verfahren im Bioelektromagnetismus; Methoden der Verifikation und Validierung im Bioelektromagnetismus; Bestimmung von Gewebeleitfähigkeiten; Bildgebung bei magnetischen Nanopartikeln; Multimodale Bildgebung am Gehirn; Informationstransfer und höherfrequente Oszillationen im somatosensorischen System; Transkranielle elektrische Stimulation); Biomedizintechnik für die Ophthalmologie (Neuro-Ophthalmologie; Simulationstechniken für das visuelle System; Mikrozirkulationsdiagnostik; Autofluorescence Lifetime Imaging.

Bioelektrische und biomagnetische Signale des Gehirns: von der Messtechnik zur Quellenrekonstruktion

Die Funktion des Gehirns ist immense komplex, jedoch gleichzeitig der Schlüssel für das Verständnis menschlichen Verhaltens und vieler Krankheiten. In den allermeisten Fällen ist eine direkte Beobachtung detaillierter Gehirnfunktion nicht möglich und so existieren viele Modalitäten zur nichtinvasiven Hirnaktivitätsmessung außerhalb des Kopfes. Die älteste dieser Methoden ist die Elektroenzephalographie (EEG; die Abkürzung EEG wird sowohl für die Elektroenzephalographie, als auch für das Elektroenzephalogramm genutzt). Sie spielt bis heute eine bedeutende Rolle in der medizinischen Diagnostik und in der neurowissenschaftlichen Forschung. Bei dieser Methode werden elektrische Potentialschwankungen auf der Kopfoberfläche registriert, die ihrerseits auf physiologisch bedingte Potentialschwankungen im Nervengewebe des Gehirns (und die damit zusammenhängenden elektrischen Ströme) zurückgehen. Diese Potentialschwankungen sind eng an die Funktion der Nervenzellen gekoppelt. Gleichzeitig entstehen biomagnetische Felder durch die körpereigenen elektrischen Ströme. Ihre Messung erfolgt durch empfindliche Magnetfeldsensoren und wird als Magnetoenzephalographie (MEG) bezeichnet. Der entscheidende Vorteil beider Methoden ist die exzellente Zeitauflösung: die neuronale Aktivität kann praktisch in Echtzeit verfolgt werden. Eine Herausforderung stellt die Bestimmung der Orte und Zeitverläufe der den gemessenen Signalen zugrundeliegenden Quellen und damit der interessierenden Hirnaktivität dar. Diese Bestimmung wird als Quellenrekonstruktion bezeichnet wird.

Im Vortrag werden aktuelle Entwicklungen in der Messtechnik für EEG und MEG vorgestellt, gefolgt von Modellierungsansätzen für die Quellenrekonstruktion und Anwendungsbeispielen.

Beim EEG dienen Elektroden als Sensoren. Je nach Kopplung zur Haut (mit oder ohne Anwendung von Pasten/Gelen) wird in nasse oder trockene Elektroden unterschieden. Bei trockenen Elektroden werden ebenso wie bei nassen Elektroden Metalle oder Ag/AgCl als Materialien eingesetzt. Trockene Elektroden bieten den Vorteil, dass selbst Hauben mit einer relativ großen Anzahl von Sensoren problemlos in kurzer Zeit und ohne zusätzliche Hilfe appliziert werden können. Dies eröffnet neue Einsatzmöglichkeiten für das EEG, beispielsweise in der Telemedizin oder im Heimbereich.

Bei der Modellierung des menschlichen Kopfes bestimmen hochauflösende Finite Elemente Modelle mit mehreren Millionen Elementen den aktuellen Stand der Technik. Der Vortrag wird einen Einblick in diese Modellierungstechniken und verschiedene Sensitivitätsanalysen, insbesondere für anisotrope Leitfähigkeit bieten.

Anwendungsbeispiele zu EEG/MEG Quellenrekonstruktion aus dem Bereich Netzwerkanalyse und Informationstransfer zwischen Hirnarealen, sowie aus dem Bereich der Musikverarbeitung im Gehirn schließen den Vortrag ab.

Vortrag am 9.10.2015

Jan Mehner (Dresden), Ordentliches Mitglied der Technikwissenschaftlichen Klasse

Professor für Mikrosystem- und Gerätetechnik an der Technischen Universität Chemnitz; Ordentliches Mitglied der Technikwissenschaftlichen Klasse seit 14. Februar 2014;

Hauptarbeitsgebiete: Methoden und Algorithmen zur Modellierung und Simulation elektromechanischer Systeme; Entwurf, Charakterisierung und Anwendungen von Mikrosystemen.

Mikrosysteme für die Industrieautomatisierung, Fahrzeugtechnik und die Medizin

Zukunftsweisende, wettbewerbsfähige Produkte sind ohne den Einsatz von Mikrosystemen nicht mehr denkbar. Hergestellt mittels moderne Mikro- und Nanotechnologien ermöglichen sie es, neben elektronischen Schaltungen auch elektromechanische, fluidmechanische und optische Komponenten direkt in Siliziumbauelemente zu integrieren. Zum Einsatz kommen diese Systeme vor allem als miniaturisierte Sensoren für die Industrieautomatisierung, Fahrzeugtechnik, Elektronikerzeugnisse und die biomedizinische Technik.

Mikromechanische Sensoren werden heute in Massenproduktion von Halbleiterherstellern wie Bosch, Freescale, Analog Device oder STMicroelectronics gefertigt. Viele Anwendungen wie die Airbag-Steuerung, die Fahrdynamikreglung und Überrolldetektion bei Fahrzeugen oder die Bewegungsteuerung in Spielekonsolen, Fernbedienungen oder Smart Phones sind erst durch diese Bauelemente möglich geworden. Für die nächsten Jahre wird die Entwicklung leistungsfähigerer Combo-Sensoren, bei denen mehrachsige und multifunktionale Sensoren in einem Gehäuse integriert sind, erwartet.

Die Modellierung und Simulation dieser komplexen und heterogenen Systeme im Vorfeld einer späteren Fertigung wird die Herausforderung für die Zukunft sein. Neben der Modellierung der komplizierten Form- und Funktionselementen sind die physikalischen Wechselwirkungen der Wandler, der Einfluss der Gehäusetechnologie, Störungen aus der Umgebung und vor allem die Interaktion mit der Ansteuer- und Auswerteelektronik zu berücksichtigen. Dabei werden deren Wechselwirkungen meist mit Finite Elemente Programmen analysiert. Für elektronische Schaltungen und Regler verwendet man Netzwerkmodelle oder Signalflussgraphen. Die Abbildung des Sensorverhaltens durch effiziente und zugleich genaue Kompaktmodelle in einer einheitlichen Simulationsumgebung ist ein zentraler Forschungsschwerpunkt der Professur.

Besonders erfolgreich ist die Professur bei der Entwicklung mikromechanischer Drehratesensoren (oft auch als Gyroskope bezeichnet). In der Luft- und Raumfahrt werden hierfür seit Jahrzehnten aufwendige und teure Kreiselsysteme verwendet. Für die Fahrdynamikregelung in Kraftfahrzeugen (Fahrdynamik-Test oder auch „Elchtest“) werden kostengünstigere Drehratesensoren eingesetzt. Diese Sensoren besitzen eine bemerkenswerte Genauigkeit, sind in ein übliches Elektronikgehäuse eingebettet und haben Fertigungskosten von unter einem Euro pro Stück.

Mikrosensoren haben Außenabmessungen im Sub-Millimeterbereich und benötigen wenige Mikrowatt an Leistung. Hieraus ergeben sich neue Anwendungen für die Zustandsüberwachung. Im Bundes-Exzellenzcluster „MERGE“ der TU Chemnitz wird die Integration der Wandler in Faserverbundwerkstoffe untersucht, um Schädigungen wie Faserrisse oder Delamination an hochbelasteten Bauteilen frühzeitig zu erkennen. Zunehmend werden Mikrosensoren auch für die Medizintechnik eingesetzt. Aktuelle Forschungsprojekte zur Druckmessung mit hochauflösenden Kathetern und autonome Druckmesskapseln werden im Vortrag vorgestellt.

Vortrag am 9.10.2015

Gudrun Schmidt (Dresden), Ordentliches Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Professorin i.R. für Technische Chemie an der Technischen Universität Clausthal; Korrespondierendes Mitglied seit 9. Februar 2001, Ordentliches Mitglied seit 2.September 2013;

Schwerpunkte: Technische und Makromolekulare Chemie; Synthese, Analyse, Reaktionstechnik von Polymeren; Modellierung von Polymerisationsprozessen.

Blick in die Welt der Farben

Pigmente und Farbstoffe mit Geschichte Die Menschen haben schon in frühester Zeit natürliche farbige Materialien (Pigmente und Farbstoffe) benutzt um durch Farben ihre Gefühle, Behausungen, Körper und Kleidung zu verschönern. Ein Zeugnis der frühesten Anwendung von Pigmenten sind die erst 1994 im Ardèche in Südfrankreich (Chauvet-Pont-d’Arc) entdeckten Höhlenmalereien, die als die ältesten der Welt (ca. 30 000 v.Chr.) gelten.

Synthetische Farbstoffe wurden erst um 1860 (Teer- bzw. Anilinfarbstoffe aus Kohle) entdeckt und nach 1890 begann die großtechnische Produktion von synthetischen Farbstoffen in verschiedensten Farbwerken, die die Basis für die heutige Chemische Industrie legten. Gegenwärtig ist das Erdöl Rohstofflieferant für die chemische Industrie, die mittlerweile eine kaum noch überschaubare Anzahl von Farbstoffen und Pigmenten für die unterschiedlichsten Anwendungsgebiete auf den Markt bringt.

Im Mittelalter hat man mit Naturfarben gefärbt, die aus Pflanzen, Flechten, Hölzern, Pilzen und Tieren, wie Purpurschnecke und Cochenillelaus ge-wonnen wurden. Die Farbe war ein wichtiges Kennzeichen der sozialen Gliederung in der mittelalterlichen Ständeordnung. Adel und hoher Klerus waren auf Luxus bedacht und trugen leuchtende und tiefe Farbtöne, ihre Kleidung bestand aus wertvollen Seide- und Wolltuchen. Die teuerste Farbe war Purpur. In Rom durfte nur der Kaiser einen purpurnen Mantel tragen. Niedrige Herkunft wurde schon deutlich durch ungefärbte oder braune, graue, schwarze meist fleckig gefärbte Kleidung dokumentiert.

Im Zuge der „Ökowelle“ wächst das Bewusstsein für „Bio“ und man erinnert sich wieder an die alten Traditionen der Naturfarbstoffe, die seit einiger Zeit eine Renaissance erleben. Die Suche nach natürlichem Ersatz für synthetische Farbstoffe (gekennzeichnet durch „E-Nummern“) in Lebensmitteln, Kosmetikprodukten oder auch Fingerfarben aus Früchten, Wurzeln, Blättern, Pilzen, Algen usw. ist ein sehr aktuelles Thema.

Im Zusammenhang mit der Historischen Farbstoffsammlung der Technischen Universität Dresden, die eine der ältesten und umfangreichsten Sammlungen von Farbstoffen, Pigmenten und historischen Farbmusterbüchern (ca. 2500) weltweit ist, soll ein kleiner Exkurs in „Pigmente und Farbstoffe mit Geschichte“ unternommen werden.

Vortrag am 12.6.2015

Joachim Mössner (Leipzig), Ordentliches Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Professor für Gastroenterologie und Direktor der Klinik und Poliklinik für Gastroenterologie und Rheumatologie; Department für Innere Medizin, Neurologie und Dermatologie; Universitätsklinikum Leipzig, AöR; Ordentliches Mitglied der Mathematisch-naturwissenschaftlichen Klasse seit 10. März 2006;

Derzeitige Forschungsschwerpunkte: Pathogenese der akuten Pankreatitis; Hereditäre chronische Pankreatitis; GWAS (genomweite Assoziationsstudien): Risikofaktoren für Pankreatitis / Klinische Forschungsschwerpunkte: Chronische Pankreatitis; Pankreaskarzinom; Gallengangskarzinom; interventionelle Endoskopie.

Mythen der Medizin: wie sie entstehen, wie sie vergehen

Ursprünglich wurde unter Μῦθος eine Rede, Erzählung, sagenhafte Geschichte, erzählerische Verknüpfung von Ereignissen verstanden. In der Neuzeit erfolgte ein Bedeutungswandel des Begriffs. Eine Polemik gegen den Wahrheitsanspruch von Mythen besteht seit Platon. Mythen in der Medizin werden in der Regel als falsche Annahmen, Behauptungen angesehen. Im Referat sollen auch die Mythen auf dem Boden der Medizingeschichte aus der Sicht eines naturwissenschaftlich denkenden Arztes beleuchtet werden.

Die Medizingeschichte kann in 4 Phasen eingeteilt werden:

Phase 1: Es besteht keinerlei Verständnis bezüglich Ätiologie und Pathogenese einer Erkrankung. Krankheit ist gottgewolltes Schicksal oder die Krankheit sei verursacht durch „Feinde“ (z.B. Judenprogrome des Mittelalters: Brunnen seien vergiftet).

Phase 2a: Analogieschlüsse zur Krankheitsursache durch Beobachtung; aber falsche Schlussfolgerung: Malaria „schlechte Luft“ der Sümpfe.

Phase 2b: Erfahrungsmedizin: Oft richtige Schlussfolgerung zur Prophylaxe und Therapie; z.B. Naturheilkunde.

Phase 3: noch heute für viele Erkrankungen zutreffend. Es besteht nur ein Teilverständnis der Pathogenese; wirkungslose oder nur teilweise wirksame Therapie. Beispiele sind die Therapie der Pankreatitis mit Proteaseninhibitoren, die immunsuppressive Therapie bei chronisch entzündlicher Darmerkrankung.

Phase 4: Verständnis der Ätiopathogenese. Folge richtige Therapie und Heilung.

Noch andauernde Phase: Parallele Inanspruchnahme der „Alternativmedizin“, wenn mittels naturwissenschaftlich basierter „Schulmedizin“ die Krankheit nicht zufriedenstellend behandelt werden kann.

Es werden eine Reihe allgemeinmedizinischer Mythen und Beispiele der „Entzauberung“ auch anhand einiger gastroenterologischer Erkrankungen vorgestellt. z.B. 2 Liter Wasser am Tag seien gesund, wir nutzen nur 10% unseres Gehirns, Haare und Nägel wachsen nach dem Tod weiter, rasierte Haare wachsen schneller nach, Lesen im Dämmerlicht schade den Augen, Handys im Krankenhaus seien gefährlich, Zucker mache Kinder hyperaktiv, nächtliches Essen mache dick, Suizidgefahr sei in der dunklen Jahreszeit erhöht, Schlaf vor Mitternacht sei der gesündeste, kalt duschen stärke die Abwehrkräfte, Sonnencreme müsse 30 Minuten einwirken, Heilfasten „entschlacke“ den Körper. Es werden aus Sicht des Referenten die fortbestehenden Mythen bezüglich Akkupunktur, Homöopathie, chinesischer -, indischer - (Ayur-Medizin), heilpraktischer Medizin angesprochen. Die Wirksamkeit dieser Verfahren ist jedoch nicht gemäß den Kriterien der wissenschaftlich fundierten, evidenzbasierten Medizin belegt. Es fehlen prospektive, randomisierte, doppel-blinde Multizenter-Studien.

Ein Beispiel aus der Gastroenterologie, die zum Ende eines Mythos führte, ist die Entdeckung des Helicobacter pylori.

Es wird diskutiert, warum gewisse Mythen fortbestehen und wie sie entzaubert werden können.

Vortrag am 12.6.2015

Foteini Kolovou (Leipzig), Ordentliches Mitglied der philologisch-historischen Klasse

Professorin für Byzantinische und Neugriechische Philologie an der Universität Leipzig, Ordentliches Mitglied der philologisch-historischen Klasse seit 14. Februar 2014;

Hauptarbeitsgebiete: Byzantinische Rhetorik, Historiographie und Epistolographie, Rezeptionsgeschichte, Editionen epistolographischer und historiographischer Texte.

Der gefangene Gelehrte und sein nächtlicher Gast. Geschichtskonzeption und Phantasie im späten Byzanz

Die Interaktion zwischen Geschichtskonzeption und Phantasie fand bisher in der byzantinistischen Forschung kaum Beachtung. Die Rhomaike Historia des Nikephoros Gregoras (1290/91-1359/60), eines geistig im antiken Hellenentum verwurzelten Humanisten und platonisierenden Universalgelehrten, eignet sich zu diesem Zweck hervorragend. Gregoras' Historia, der umfangreichste und in seiner Erzählstruktur komplexeste von allen überlieferten byzantinischen historiographischen Texten, entstand in einer bewegten, von innen- und kirchenpolitischen Auseinandersetzungen gekennzeichneten Zeit, innerhalb deren der theologische Hesychasmus-Diskurs, im 14. Jahrhundert bekannt auch als Palamismus-Streit, das wichtigste kirchenpolitische Ereignis in Byzanz zwischen 1341 und 1351 darstellte.

Am Beispiel einer rätselhaften Figur, des Agathangelos, der in der Historia als Schüler und nächtlicher Gesprächspartner des Gregoras erscheint, wird die Bedeutung von Rhetorik und Mimesis in der byzantinischen Historiographie, der Königsdisziplin der Byzantiner, thematisiert. In diesem Zusammenhang werden auch die Rolle der Phantasie bei der Repräsentation der Vergangenheit sowie die Veränderung des Geschichtsdenkens unter Einfluss des Christentums behandelt.

Vortrag am 8.5.2015

Bernard Comrie (Leipzig), Ordentliches Mitglied der Philologisch-Historischen Klasse

Direktor der Abteilung Linguistik am Max-Planck-Institut für evolutionäre Anthropologie, Honorarprofessor an der Universität Leipzig und Professor für Linguistik an der University of California Santa Barbara; Ordentliches Mitglied der Philologisch-Historischen Klasse seit 12. Februar 1999;

Hauptarbeitsgebiete: Sprachtypologie; Sprachevolution; Dokumentation bedrohter Sprachen, insb. in Neuguinea und dem Nordkaukasus.

Zahlensysteme der Welt

Die Zahlensysteme der Welt sind nicht nur außergewöhnlich vielfältig, sondern gestatten auch einen Einblick in den Zusammenhang zwischen Sprache und Kultur. Sie reichen von den beschränkten Systemen einiger Jäger und Sammler über körperteilbasierte Systeme bis zu ausgewachsenen Systemen mit Basen nicht nur von 10 und 20, sondern auch von 8, 12 und 23, welchen nicht nur Addition und Multiplikation, sondern auch Subtraktion und andere kompliziertere mathematische Operationen zugrunde liegen.

Anhand eines reichen empirischen Materials wird die arithmetische Struktur von Zahlensystemen dargestellt, insbesondere die verschiedenen arithmetischen Basen – im Zusammenhang mit kulturellen Faktoren –, die arithmetischen Prozesse, die bei der Bildung höherer Zahlen angewandt werden so-wie die Reihenfolge der Konstituenten bei zusammengesetzten Zahlen.

Vortrag am 8.5.2015

Jens-Peter Majschak (Dresden), Ordentliches Mitglied der Technikwissenschaftliche Klasse

Professor für Verarbeitungsmaschinen/Verarbeitungstechnik an der Technischen Universität Dresden; Ordentliches Mitglied der Technikwissenschaftliche Klasse seit 8. Februar 2013;

Hauptarbeitsgebiete: Bewegungstechnik, Umformen von Faserstoffen und Kunststoffen, Automatische Reinigungssysteme; Forschungs- und Entwicklungsdienstleistung hauptsächlich für den Verpackungsmaschinenbau, Packmittelhersteller und abpackende Industrie.

Adaptive Verarbeitungssysteme für moderne Konsumgüterproduktion

Verarbeitungsmaschinen stellen aus Natur- und Kunststoffen Massenbedarfsgüter für den täglichen Konsum mit hoher Produktivität her. In verfahrenstechnischen Prozessen werden zuvor aus Rohstoffen Grundstoffe hergestellt, die durch Weiterverarbeitung in Verarbeitungssystemen zu Produkten mit geometrisch definierter Form diskretisiert, mit den gewünschten Eigenschaften versehen und verpackt werden müssen. Zur Klasse der Verarbeitungsmaschinen gehören Kunststoff-, Glas-, Keramik-, Papier-, Papierverarbeitungs-, Nahrungsmittel-, Pharmazeutische, Druck- und Verpackungsmaschinen sowie zahlreiche Sondermaschinen.

Konsumgüter sind Güter, die der Bedürfnisbefriedigung der Konsumenten dienen und werden unterteilt in Gebrauchsgüter und Verbrauchsgüter. Aufgrund der zweckbedingt kurzen Lebensdauer der Verbrauchsgüter, deren wichtigste Vertreter die Lebensmittel sind, und des stetigen massenhaften Bedarfs gehört ihre Produktion zu den ressourcenintensivsten neben der Bauwirtschaft. Wesentliches Merkmal einer modernen Konsumgüterproduktion ist daher neben einer hohen Prozesssicherheit im Sinne sicherer Endprodukte für den Verbraucher und der Fähigkeit, bedarfsgerecht zu produzieren, eine hohe Ressourceneffizienz.

Der gewöhnliche Zielkonflikt zwischen bedarfsgerechtem und effizientem Produzieren erzeugt das vieldimensionale Spannungsfeld für den Betrieb und die Entwicklung von Produktionssystemen für die Konsumgüterproduktion. Wesentliche Treiber sind dabei: wachsender Bedarf durch die Zunahme der Weltbevölkerung und durch einen im Zuge der Industrialisierung steigenden Wohlstand; Urbanisierung wesentlicher Teile der Weltbevölkerung, die zusammen mit steigenden Einkommen zu einer Verschiebung und zunehmenden Differenzierung von Verbrauchsgewohnheiten und Bedürfnissen führt sowie die Endlichkeit benötigter Ressourcen.

Die „Gewöhnlichkeit“ der Endprodukte täuscht leicht über die Komplexität der Herausforderungen und über den Anspruch der Mittel und Methoden zur Bewältigung dieser Herausforderungen hinweg. Die Stellung von Verarbeitungsmaschinen in der Wertschöpfungskette führt insbesondere im Haupteinsatzgebiet der Lebensmittelverarbeitung und -verpackung dazu, dass sich in ihnen komplexe Stoff-, Energie- und Informationsströme bündeln. Es werden vorwiegend Verarbeitungsgüter aus biogenen Stoffen oder Kunststoffen verarbeitet, deren Verarbeitungsverhalten wegen stark vernetzter, schwankender und oft unbekannter Einflussparameter nicht hinreichend oder nur mit erheblichem Aufwand analysierbar und modellierbar ist. Hinzu kommt die Komplexität von Systemen, in denen in der Regel große Teile der Herstellung sowie die Verpackung vom unverpackten Produkt bis hin zur beladenen und gekennzeichneten Palette verkettet und vollautomatisch ablaufen. Markant für die eingangs erwähnte wohlstandsgetriebene Veränderung von Gewohnheiten und Bedürfnissen sind u.a. neue, internetbasierte Vertriebswege sowie der damit eng verbundene Trend zu individuell gestalteten Produkten. Dies führt zunehmend zur informationellen Verknüpfung von Bestell-, Produktions-, Auslieferungs- und Abrechnungsprozessen. Neben der steigenden Durchdringung von Verarbeitungssystemen durch Software wächst damit auch der Bedarf an hoch flexiblen Technologien. Beides sind Voraussetzungen für eine individualisierte und dennoch effiziente Massenproduktion.

An einem Technologiebeispiel wird gezeigt, wie gravierend sich diesbezüglich Innovationen in der Massengüterproduktion auf Ressourceneffizienz auswirken können. Es wird verdeutlicht, welche Chancen, aber auch Herausforderungen in der Umsetzung derartiger Technologien liegen.

Festvortrag zur Öffentlichen Frühjahrssitzung am 10.4.2015

Wilfried Hofmann (Dresden), Ordentliches Mitglied der Technikwissenschaftlichen Klasse

Professor für Elektrische Maschinen und Antriebe, Geschäftsführender Direktor des Elektrotechnischen Instituts, TU Dresden; Ordentliches Mitglied der Technikwissenschaftlichen Klasse seit 10. März 2006, seit 2012 Sekretar der Klasse;

Hauptarbeitsgebiete: Entwurf und Optimierung elektrischer Maschinen, Maschinenumrichter und -regelungen, Magnetlagertechnik, Leistungselektronik, Anwendungen in Wind- und Wasserkraftanlagen sowie in Elektro- und Hybridfahrzeugen.

Elektromaschinen – Die Arbeitspferde der Industriegesellschaft

Die elektrischen Maschinen haben seit ihrer mehrfachen Erfindung in der ersten Hälfte des 19. Jahrhunderts eine bemerkenswerte Entwicklung erfahren, die anfangs von heftigen Rückschlägen, langwierigen Durchsetzungskämpfen und plötzlichen Wendungen begleitet war, um später schließlich eine rasante Ausbreitung zu erfahren. Der eigentliche Durchbruch ist mit der Einführung des Wechselstroms in der Stromerzeugung erfolgt, mit dem eine verlustarme zunächst regionale später landesweite Energieversorgung der Industrie möglich wurde. Ebenso wichtig für ihre Ausbreitung in Industrie und Handwerk war der gefahrenlose Einsatz als Antriebsmotor in angepasster Skalierung von Bau- und Leistungsgrößen.

Bis heute haben kontinuierliche Fortschritte in der Theorie und Berechnung, der Konstruktion und bei Werkstoffen, der Kühltechnik und in der Fertigung zur Steigerung der Maschinenausnutzung geführt. Sie wird je nach Anwendungsfall durch die Leistungs- oder Drehmomentdichte beschrieben. Während die Entwicklungen bei Elektromotoren in der Regel zu immer kompakteren Lösungen geführt haben, konnten bei Turbogeneratoren die realisierbaren Grenzleistungen immer weiter gesteigert werden. Einen besonderen Schub hat die Anwendung von Elektromaschinen durch ihre Ausstattung mit Steuer- und Regelelektronik erfahren, mit der sie in der Lage sind, variable Drehzahlen einzustellen und anforderungsgerecht dosierte Bewegungen auszuführen. In besonderen Auslegungen als Direktantriebe helfen sie Getriebe und andere mechanische Komponenten zu ersetzen. Diese neuen Eigenschaften sind nicht nur gefragt, um industrielle Prozesse effektiver zu betreiben, sondern sie schaffen auch für Werkzeugmaschinen qualitativ neue Möglichkeiten zur Hochgeschwindigkeitsbearbeitung. Obgleich der Anforderungskatalog an Elektromaschinen sehr breit gefächert ist, spielen die Kosten eine dominierende Rolle. Eine Analyse der Lebenszykluskosten zeigt, dass die Energiekosten über die lange Lebensdauer gerechnet die Investitionskosten um ein Vielfaches übertreffen. Deshalb gibt es im letzten Jahrzehnt weltweite Bemühungen, um den Wirkungsgrad von Elektromotoren international in Effizienzklassen zu standardisieren. Damit hat teilweise eine gegenläufige Entwicklung eingesetzt, die auf einen höheren Materialeinsatz oder Materialsubstitution abzielt. In Zukunft wird es deshalb darauf ankommen, eine ausgewogene Ressourcenökonomie durch. Energie- und Materialeffizienz zu erreichen. Neben diesen durch angewandte Forschung getriebenen Langzeitentwicklungen sind wesentliche technologische Sprünge im Elektromaschinenbau durch den Einsatz von neuen Hochtemperatur-Supraleitern, den Übergang auf eine Transversalflussbauweise oder die Einführung von Drucktechnologien zu erwarten, wenn sie durch eine intensive Grundlagenforschung begleitet werden.

Vortrag am 13.3.2015

Stefan Sinzinger (Ilmenau), Ordentliches Mitglied der Technikwissenschaftlichen Klasse

Professor für Technische Optik an der Technischen Universität Ilmenau; Ordentliches Mitglied der Technikwissenschaftlichen Klasse seit 14. Februar 2014;

Hauptarbeitsgebiete: Entwurf, Fabrikation, Integration, Charakterisierung und Anwendung optischer Bauelemente und Module, Freiform Optik, optische Mikrosysteme.

Die „Kunst“ des optischen Systemdesigns

Die Lichtausbreitung durch klassische optische Systeme für abbildende oder beleuchtende Anwendungen wird durch einfache physikalische Gesetze wie das Brechungs- und Reflexionsgesetz exakt beschrieben. Trotzdem diese Gesetze seit vielen Jahrhunderten bekannt sind, stellt die Optimierung optischer Systeme immer noch eine spannende Herausforderung dar. Die Suche nach den Ursachen hierfür führt von den physikalisch-technischen Grundlagen der Beschreibung elektromagnetischer Wellen und optischer Systeme bis zu den neuen Entwicklungen und Forschungstrends.

Warum ist die Öffnung des Objektivs meiner Fotokamera rund? Diese Frage, die eine als selbstverständlich wahrgenommene Eigenschaft optischer Bauelemente hinterfragt, führt auf eines der spannendsten Forschungsthemen, das aktuell im Bereich der Technischen Optik diskutiert wird. Optische Bauelemente ohne Rotationssymmetrie, sog. „Freiformflächen“ stellen dabei den zentralen thematischen Schwerpunkt dar. Wie und für welche Anwendungen kann die vergrößerte Zahl an Freiheitsgraden in solchen optischen Freiformflächen gewinnbringend eingesetzt werden? Insbesondere wenn es darum geht optische Systeme kompakt oder mit reflektierenden Bauelementen aufzubauen, steigt die Bedeutung nicht-rotationssymmetrischer Bauelemente zur Vermeidung von Abbildungsfehlern. Eines von zahlreichen Anwendungsbeispielen sind sog. „head-mounted“ oder „head-up displays“, die bereits heute in Kraftfahrzeugen eingesetzt werden, um die Anzeige von Navigationssystemen oder Armaturenbrett in das Blickfeld des Fahrers einzuspiegeln. Am Fachgebiet Technische Optik werden unkonventionelle Freiformflächen insbesondere für optische Mikrosysteme und adaptive optische Bauelemente erforscht.

Die Einbeziehung des Beleuchtungsregimes in die Optimierung ermöglicht eine weitere Steigerung der Leistungsfähigkeit. Photolithographische Systeme stellen beispielsweise die am höchsten entwickelten optischen Systeme dar. Wie ist es möglich, dass damit Strukturen erzeugt und aufgelöst werden können, die kleiner sind als ein Zehntel einer Wellenlänge? Wie arbeiten bildgebende Verfahren, die jenseits des sog. Abbe-Limits arbeiten? Anhand dieser Fragen werden einige Grundprinzipien der optischen Systeme erläutert und die Herausforderungen an den Optik-Designer veranschaulicht.

Vortrag am 13.3.2015

Josef A. Käs (Leipzig), Ordentliches Mitglied er Mathematisch-Naturwissenschaftlichen Klasse

Professor für Experimentalphysik / Physik weicher Materie mit Schwerpunkt Zellbiophysik an der Universität Leipzig; Ordentliches Mitglied der Mathematisch-naturwissenschaftlichen Klasse seit 14. Februar 2014;

Hauptarbeitsgebiet: Beschreibung von Zellen als einen neuen aktiven Zustand weicher Materie.

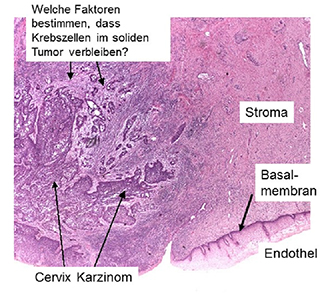

Die Stabilität von Tumorrändern

Die Physics of Cancer oder auch physikalische Onkologie ist ein schnell wachsendes, neues wissenschaftliches Feld an der Grenze zwischen Biophysik, Tumorbiologie und Medizin. Für solide Tumore haben die mechanischen und adhäsiven Materialeigenschaften der Krebszellen und der Mikroumgebung einen fundamentalen Einfluss auf die lokale Tumorinvasion.

Die Soft Matter Physik hat profunde Erfahrung in der quantitativen Beschreibung von statischen und dynamischen Segregationsprozessen, die sich auf Zellsegregation übertragen lassen. Mit diesem Ansatz lassen sich grundlegende und inhärente physikalische Mechanismen postulieren, die die Tumorgrenze stabilisieren und deshalb lokale Invasion mitbestimmen.

Diese Ergebnisse können zu einer genaueren Definition von Tumorrändern und zu neuen prognostischen Tumormarkern führen.

Vortrag am 13.2.2015

Sigurd Lenzen (Hannover), Korrespondierendes Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Professor für Klinische Biochemie, Direktor des Instituts für Klinische Biochemie an der Medizinischen Hochschule Hannover, Korrespondierendes Mitglied der Mathematisch-naturwissenschaftlichen Klasse seit 14. Februar 2014;

Hauptarbeitsgebiete: Regulationsmechanismen der glukoseinduzierten Insulinsekretion; Klärung der Mechanismen der Betazell-Toxizität und Diabetogenität von Alloxan und Streptozotocin; Untersuchungen zu den molekularen Mechanismen proinflammatorischer Zytokine im Typ 1 Diabetes sowie der Glucolipotoxizität im Typ 2 Diabetes; Entwicklung neuer präventiver und kurativer Therapien im Tiermodell zur Behandlung des Typ 1 Diabetes sowie die Etablierung eines neuen Modells zur Untersuchung des humanen Typ 1 Diabetes, der spontan diabetischen IDDM (LEW.1AR1- iddm) Ratte.

Die Diabetes-Epidemie – warum sind die insulinproduzierenden ß-Zellen des endokrinen Pankreas so vulnerabel?

Die Diabeteshäufigkeit ist im letzten halben Jahrhundert in Deutschland um mehr als das Zwanzigfache angestiegen. Dies gilt für den Typ 1 Diabetes und noch mehr für den Typ 2 Diabetes. Der Typ 1 Diabetes ist eine Autoimmunerkrankung, die bei Kindern und Jugendlichen auftritt, aber auch jeden zehnten erwachsenen Diabetiker betrifft. Der Typ 2 Diabetes ist die wesentlich häufigere Form der Erkrankung, die bei 90 % der Diabetiker vorliegt. Der Typ 2 Diabetes ist eine Stoffwechselerkrankung, die bevorzugt bei Erwachsenen im mittleren und höheren Alter auftritt und in der überwiegenden Zahl der Fälle mit Übergewicht gepaart ist.

Die insulinproduzierenden Betazellen in den Langerhans’schen Inseln des Pankreas zeichnen sich im Vergleich zu anderen Zelltypen und Organen durch eine besondere Vulnerabilität aus, bedingt durch einen schlechten Schutz gegenüber oxidativem Stress. Für die durch proinflammatorische Zytokine vermittelte Zerstörung der Betazellen, die im Typ 1 Diabetes zur Insulinpflichtigkeit der Patienten führt, spielen zytotoxische freie Radikale, sowohl reaktive Sauerstoff- als auch reaktive Stickstoffspezies, eine zentrale Rolle. Die verantwortlichen Pathomechanismen werde ich in meinem Vortag darlegen. Auf der Grundlage des Verständnisses der molekularen Pathomechanismen ist es nun auch möglich, zumindest in der Frühphase der Erkrankung, kurative Therapien zu etablieren.

Die Situation im Typ 2 Diabetes ist komplexer. Der Krankheitsverlauf ist in der Frühphase in der Regel milder, es kommt zunächst nur zu einer Dysfunktion der insulinproduzierenden ß-Zellen und erst später auch zu einem Verlust der insulinproduzierenden Zellen. Daher kann eine Behandlung zunächst häufig mit oralen antidiabetischen Wirkstoffen erfolgreich durchgeführt werden. Erhöhte Fettsäurekonzentrationen in der Zirkulation spielen in diesem Krankheitsprozess zusammen mit den erhöhten Blutglucosekonzentrationen offenbar eine wichtige Rolle. Man spricht daher auch von einer so genannten „Gluco-Lipotoxizität“. Bei den zugrunde liegenden Pathomechanismen spielt die Toxizität von freien Sauerstoffradikalen ebenfalls eine zentrale Rolle. Neuere Befunde zu den Mechanismen der „Gluco-Lipotoxizität“ führen auch zu ganz neuen Implikationen, was eine gesunde Ernährung anbetrifft, die vor der Entwicklung des Typ 2 Diabetes schützen könnte.

Zusammenfassend lässt sich feststellen, dass den beiden Krankheitsformen, dem Typ 1 und dem Typ 2 Diabetes, offenbar ganz unterschiedliche Pathomechanismen zugrunde liegen. Die Vorstellung, dass proinflammatorischen Zytokinen, insbesondere dem Interleukin1-ß, eine wichtige Rolle auch in der Pathogenese der ß-Zelldysfunktion im Typ 2 Diabetes zukommt, ist über viele Jahre von einer großen Zahl von Wissenschaftlern vertreten worden. Neueste Entwicklungen weisen jedoch darauf hin, dass dieses Konzept nicht valide ist.

Vortrag am 13.2.2015

Rüdiger Lux (Leipzig), Ordentliches Mitglied der Philologisch-historischen Klasse

Universitätsprofessor i.R. für Exegese und Theologie des Alten Testaments an der Universität Leipzig; Ordentliches Mitglied der Philologisch-historischen Klasse seit 14. Februar 2003;

Hauptarbeitsgebiete: Biblische Narratologie (Jona, Josef), Prophetie der Perserzeit (Haggai, Sacharja), nachexilische Weisheitsliteratur (Hiob, Qohelet), Biblische Hermeneutik.

Die Tochter Jiftachs − eine hebräische Iphigenie? Israels Auseinandersetzung mit dem Phänomen des Tragischen in Richter 10,6-12,7

Die attische Tragödie wurde im antiken Griechenland des 6. und 5. Jh. v. Chr. zur prägenden literarischen Gestalt für die Darstellung eines tragischen Welt- und Lebensgefühls. Als solche prägte sie die dramatische Dichtung bis in die Neuzeit. Da sich Widerfahrnisse des Tragischen aber nicht auf die Kultur der alten Griechen beschränken, sondern ein allgemeines Menschheitsproblem darstellen, stellt sich die Frage, wie diese Erfahrungen in den Nachbarkulturen des östlichen Mittelmeerraumes literarisch aufgenommen und verarbeitet wurden.

Zum Vergleich bietet sich die im Alten Testament überlieferte Welt der Sagen und Erzählungen an. In der exegetischen Forschung wurden einzelne Figuren und die über sie berichteten Geschehnisse zwar immer wieder in einem ganz allgemeinen und unspezifischen Sinne als »tragisch« bzw. als »Tragödie« bezeichnet (W. Dietrich, G. Hentschel, M. Bauks u.a.). Die Frage aber, was denn eigentlich das Tragische an diesen sei und wie es zur Darstellung komme, blieb ausgespart.

Ein Grund für dieses Desiderat der alttestamentlichen Forschung ist aller Wahrscheinlichkeit nach in der Positionsbestimmung prominenter evangelischer Theologen des 20. Jh. zum Problem des Tragischen zu sehen (K. Barth, D. Bonhoeffer, P. Althaus, H. Thielecke u.a.). Sie vertraten die Auffassung, dass in der durch die Gnade Gottes versöhnten Welt des christlichen Glaubens das Tragische ein für alle Mal überholt worden sei. Daher sei auch »das tragische Lebensgefühl dem Alten Testament fremd« (K. H. Miskotte).

Diese These soll im folgenden Vortrag einer kritischen Überprüfung unterzogen werden. Als exemplarische Textgrundlage dazu dient die Jiftachtradition in Ri 10,6-12,7. Die in dieser Tradition verarbeitete Episode von der Opferung der Tochter Jiftachs (11,29-40) enthält unübersehbare Gemeinsamkeiten mit der griechischen Iphigenie-Tradition, worauf bereits mehrfach hingewiesen wurde. Dabei gingen die bisherigen Untersuchungen allerdings nicht über einen Motivvergleich und die Erörterung möglicher Abhängigkeiten hinaus (W. Baumgartner, Th. Römer, A. Kunz-Lübcke, M. Bauks u.a.).

Die Frage, wie das tragische Potenzial dieser Episode in die gesamte Jiftachtradition und die deuteronomistische Geschichtstheologie des Alten Testaments integriert und in ihr verarbeitet wurde, fand bisher so gut wie keine Beachtung. Im Ergebnis unserer Fragestellung wird sich zeigen, dass das Phänomen des Tragischen in diesem Text weder theologisch entschärft, noch überholt wurde, sondern ganz im Gegenteil dazu eine radikale Zuspitzung erfuhr. Damit stellt sich für die biblische Exegese künftig die Aufgabe, sich des in der biblischen Theologie vernachlässigten Themas des Tragischen neu anzunehmen.

Im interkulturellen Diskurs mit der griechischen Tragödienliteratur gilt es, die Gemeinsamkeiten und die speziell biblischen Profilierungen der Thematik zu analysieren.

Vortrag am 9.1.2015

Manfred Rudersdorf (Leipzig), Ordentliches Mitglied der Philologisch-historischen Klasse

Professor für Geschichte der Frühen Neuzeit am Historischen Seminar der Universität Leipzig; Ordentliches Mitglied der Philologisch-historischen Klasse seit 9. Februar 2001;

Hauptarbeitsgebiete: Reformations- und Konfessionalisierungsgeschichte, Verfassungs- und Sozialgeschichte des Alten Reiches und seiner Territorien, Vergleichende Kultur-, Bildungs- und Universitätsgeschichte der Frühen Neuzeit.

Universitas semper reformanda. Zu einem Grundkonflikt neuzeitlicher Universitätsgeschichte im Jahrhundert der ReformationIm

Mittelpunkt der Ausführungen steht die Frage nach der Bedeutung der Institution „Universität“ für den langgestreckten Formationsprozess des geistig-kulturellen Wandels im 16. Jahrhundert, der wie nie zuvor zu einer dauerhaften Neuvermessung der politischen und der konfessionellen Grundlagen der Territorienwelt in der neuzeitlichen Geschichte beigetragen hat. So war das Reformationszeitalter im Besonderen geprägt von dem gemeineuropäisch bedeutsamen Grundkonflikt eines dialektischen Spannungsgefüges zwischen den Normen der neuen Konfessionsorthodoxie und denjenigen der humanistischen Denkkultur.

Im Kern ging es dabei um die umkämpfte Gratwanderung der Durchsetzung des konfessionellen obrigkeitlichen „Bekenntniszwangs“ und dem, was wir modern als „akademische Lehrfreiheit“ bezeichnen. Dem humanistischen Projekt einer antikegeleiteten Akkulturation erwuchs mit der Reformation zu Beginn des 16. Jahrhunderts eine überaus starke Konkurrenz, die sich gerade im Ursprungsland der deutschen Reformation, im Kurfürstentum Sachsen mit seinen beiden evangelischen Modelluniversitäten in Wittenberg und Leipzig, im Kontrast von Konformitäts- und Nonkonformitätsmechanismen artikulierte. Nicht vorrangig humanistische, sondern religiöse Streitfragen standen für ein Jahrhundert im Vordergrund des Diskurses. Der sogenannte Schulhumanismus wurde ungeachtet signifikanter Gestalten wie Melanchthon (Wittenberg), Camerarius (Leipzig), Sturm (Straßburg) und Chyträus (Rostock) zurückgedrängt, die humanistische Sozietätsbewegung verlor erkennbar an intellektueller Gestaltungskraft. Erst mit erheblicher Verspätung erstarkten die humanistischen Kräfte wieder in Deutschland und bildeten im Geiste des reformierten Späthumanismus die Keimzelle für die Entfaltung einer neuen deutschen Sprach- und Literaturkultur.

Am Beispiel der im 16. Jahrhundert zeitweise größten deutschen Universität Leipzig geht der Vortrag in gebotener Kürze insbesondere den Fragen nach, wie die Studia humanitatis den Sieg der lutherischen Konfessionalisierung mit ihrer konkurrierenden Ausgrenzungsdynamik überstanden hat, ob die Kultur des Humanismus mit der Kultur der konfessionellen Orthodoxie überhaupt in Übereinstimmung zu bringen war, schließlich inwieweit die humanistische Bildungsreform des 16. Jahrhunderts lange vor der Aufklärung zu einem Denken in Kategorien der Säkularität beigetragen hat.

Vortrag am 9.1.2015

Ulrich Groß (Freiberg), Ordentliches Mitglied der Technikwissenschaftlichen Klasse

Professor für Technische Thermodynamik an der TU Bergakademie Freiberg; Ordentliches Mitglied der Technikwissenschaftlichen Klasse seit 12.02.1999;

Hauptarbeitsgebiete: Untersuchung thermophysikalischer Stoffeigenschaften, speziell im Hochtemperaturbereich und in porösen Strukturen; Wärmeübergang bei Verdampfung und Kondensation; Benetzungsverhalten von Filmströmungen; Geothermie; Energieautarke Gebäude; Optimierung von industrieller Wärmetransportprozesse.

Wärmetransport in offenporigen Schaumstrukturen – experimentelle Ansätze

Offenporige Schäume besitzen je nach strukturellem Aufbau, Geometrie und Grundmaterial günstige Eigenschaften für vielerlei technische Anwendungen. Sie sind durch eine meist hohe Porosität, eine große volumenbezogene Oberfläche, eine geringe Dichte bei gleichzeitig hoher Festigkeit gekennzeichnet und finden sich in vielerlei Form in technischen Systemen: zur Schalldämmung, als Crash-Absorber, als Leichtbaustrukturen, als Katalysatorträger und anderes mehr. Ihre Verwendung auf dem Gebiet der Wärmeübertragung ist verhältnismäßig jung und von stark wachsendem Interesse. In nichtdurchströmtem Zustand eignen sich derartige Schäume für die Wärmedämmung, Metallschäume finden im Bereich der regenerativen Wärmeübertrager (mit eingelagertem Phasenwechselmaterial) und der rekuperativen Wärmeübertrager Verwendung.

Keramikschäume eignen sich als Struktur für sogenannte Porenbrenner (ohne offene Flamme) oder für die Metallfiltration (beim Gießen von Aluminium oder Stahl).

Der Wärmetransport ist dabei durch die gekoppelten Vorgänge der Wärmeleitung (im Feststoff und in den fluidgefüllten Poren) und der Strahlung im Porenraum gekennzeichnet, bei durchströmten Strukturen überlagern sich Prozesse der konvektiven Wärmeübertragung (über die innere Oberfläche zwischen Pore und Feststoff) sowie der Dispersion (als einer verstärkten Quervermischung).

Der Vortrag beschäftigt sich mit den experimentellen Möglichkeiten für die Untersuchung der einzelnen Beiträge zum Wärmetransport offenporiger Schaumstrukturen. Ausgehend von einigen Anwendungsbeispielen wird zunächst auf den einfacheren Fall nichtdurchströmter Anordnungen eingegangen, indem die Grundlagen und daraus entwickelte typische Messverfahren vorgestellt und im Zusammenhang mit auftretenden Problemen diskutiert werden.

In einem zweiten Teil folgt dann eine Erweiterung auf den wesentlich komplexeren Fall zwangsdurchströmter Strukturen. Es werden beispielhaft ausgewählte Versuchsanordnungen einschließlich der zugrundliegenden Methodik vorgestellt – einerseits für die Durchströmung mit Luft und andererseits für eine Anwendung zur Filtration einer flüssigen Aluminiumlegierung.