Vortrag am 14.12.2012

Annette Beck-Sickinger (Leipzig), Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Dr. rer. nat., Professorin für Biochemie und Bioorganische Chemie am Institut für Biochemie der Universität Leipzig, am 13. Februar 2009 zum Ordentlichen Mitglied gewählt.

Forschungsschwerpunkte: Struktur-Wirkungsbeziehungen von Neuropeptiden, Peptidhormonen und Chemokinen; Therapeutische Peptide und Peptidmimetika; Signaltransduktion von G-Protein gekoppelten Rezeptoren; chemische Modifizierung von Peptiden und Proteinen; Immobilisierung von Peptiden und Proteinen für nanotechnologische Anwendungen

Werkzeuge und Wirkstoffe für G-Protein gekoppelte Rezeptoren

Jede unserer Körperzellen ist von einer Zellmembran umgeben, die für die allermeisten Substanzen undurchlässig ist. Information, die zwischen den Zellen ausgetauscht wird, muss daher über die Zellmembran gelangen. Die Botschaft kann dabei vielfältig sein, von anderen Zellen oder auch von außen kommen. Typische Botschaften von außen sind Geruchs- und Geschmacksmoleküle: wir riechen Kaffee (2-Furfurylmercaptan), Vanille (4-Hydroxy-3-methoxybenzaldehyd, Vanillin) oder schmecken Zucker oder Bitterstoffe. Chemische Botschaften, die Zellen aussenden können, werden Neurotransmitter, Hormone oder Mediatoren genannt. Sie weisen den Rest des Körpers darauf hin, dass lokal Entzündungen entstanden sind, eine Stresssituation vorliegt, oder einfach dass Nährstoffe fehlen und der Organismus „hungrig“ ist. Je nach Botenstoff setzen unterschiedliche Körperzellen diese chemisch höchst verschiedenen Signalstoffe frei: kleine endogene Amine, wie das Stresshormon Adrenalin, Lipide, wie die Fieber erzeugenden Mediatoren der Prostaglandinfamilie, Peptidhormone, wie die Regulatoren der Nahrungsaufnahme oder Proteine, wie die Chemokine, die andere Zellen anlocken und eine Bedeutung in der Geweberegeneration haben. An benachbarte Zellen, über den synaptischen Spalt oder in der Blutbahn wandern diese Botenstoffe nun bis zu den Zielzellen, die die entsprechenden Rezeptoren tragen. Die Rezeptoren aller oben aufgeführten Botenstoffe, externe wie interne Signalmoleküle, haben einen gemeinsamen Bauplan und ein gemeinsames Wirkprinzip: es sind die G-Protein gekoppelten Rezeptoren, kurz GPCR. Wie arbeiten nun diese Rezeptoren, um die Information von außen in die Zelle zu tragen? G-Protein gekoppelte Rezeptoren sind große Proteine, die üblicherweise zwischen 350 und 700 Aminosäuren enthalten. Sie zeichnen sich dadurch aus, dass sie alle aus sieben Transmembran durchspannende Segmenten aufgebaut sind, die durch drei extrazelluläre und drei intrazelluläre Schleifen verbunden sind, den N-Terminus jeweils extrazellulär und den C-Terminus intrazellulär lokalisiert haben. Allerdings sind sie in ihrer dreidimensionalen Struktur dabei nicht plattgedrückt, sondern die Helices sind – von außen betrachtet – in einem Oval gegen den Uhrzeigersinn angeordnet.

Ein Drittel der heute auf dem Markt befindlichen Medikamente wirkt über GPCR. Dazu gehören Medikamente, die den Blutdruck beeinflussen, wie die „beta-Blocker“ oder Juckreiz-stillende Salben, die Histaminantagonisten enthalten. Auch Schmerzmittel wie Morphine wirken an GPCR, in diesem Fall dem sogenannten µ-Opioidrezeptor, und Medikamente zur Therapie von Schizophrenie, Angst, Allergien, Übelkeit, Migräne oder Asthma – um nur einige typische Anwendungen zu nennen. GPCR sind somit seit langem eine wichtige Klasse an Zielmolekülen in der pharmazeutischen Industrie, da man seit langem weiß, dass viele Krankheiten, Fehlregulationen und Missfunktionen im Körper darauf beruhen, dass zuviel oder zuwenig eines Botenstoffes vorhanden ist, oder der entsprechende Rezeptor nicht in genügender Menge oder Aktivität vorhanden ist oder in zu großer Anzahl mit überschießender Funktion. Hier kann man nun mit gezielt hergestellten Aktivatoren oder Inaktivatoren ansetzen und neue Moleküle mit definierter Aktivität entwickeln. Als Werkzeuge tragen diese dazu bei, die Wirkweise der Rezeptoren zu verstehen; als Wirkstoffe haben sie in der Gesundheitsforschung eine große Bedeutung.

Vortrag am 14.12.2012

Elke Blumenthal (Leipzig), Mitglied der Philologisch-historischen Klasse

Dr. phil., Professorin i. R. für Ägyptologie an der Universität Leipzig; am 8. Februar 1991 zum Ordentlichen Mitglied gewählt.

Mitglied des Ehrenrates; Forschungsgebiete: altägyptische Literatur, Königsideologie und Religion, Wissenschaftsgeschichte der Ägyptologie

Das schwangere Nilpferd und andere Gottheiten. Polytheistische Frömmigkeit unter den Pharaonen

In der allgemeinen Wahrnehmung wird das Alte Ägypten über seine Religion definiert. Vor allem Pyramiden und Mumien, aber auch „hundsköpfige Götter“ (so, abschätzig, Goethe) gelten als seine kulturgeschichtlichen Leitfossilien.

Für uns Heutige steht nicht der in Ägypten intensiv betriebene Totenkult, sondern die Gott-Mensch-Beziehung im Zentrum von Religion. Zu pharaonischer Zeit war sie durch den Staat geregelt. In den zahlreichen Tempeln des Landes wurden den zahlreichen Göttern täglich Opfergaben dargebracht und zu besonderen Anlässen große Feste gefeiert. Einziger Akteur war der Theorie nach der König, allenfalls unterstützt von Hilfspersonal; in der Praxis wurde er von Heerscharen von Priestern vertreten. Die ausschließliche Berechtigung zum Umgang mit den Göttern verlieh ihm göttliche Dignität, doch stand er ihnen zugleich als Vertreter des von ihm regierten Volkes gegenüber und empfing als Gegengabe für seine Opferdienste Segen und Gedeihen für sein Land.

Die Belange des Individuums waren in dieses umfassende Geschehen einbezogen, wenn auch in sehr allgemeiner Form. Daneben lassen sich seit frühester Zeit (3. Jtsd. v. Chr.) Spuren dafür nachweisen, dass der Einzelne mit seinen persönlichen Anliegen Gottesnähe suchte. Für die von jüdisch-christlichen Traditionen geprägte ägyptologische Forschung stellte sich dabei die Frage, wie er sich zu der Vielzahl von Göttern verhalten habe, mit denen er sich konfrontiert sah.

Anhand der Votivstele für eine populäre Göttin (das „schwangere Nilpferd“) aus dem 13. Jh. v. Chr., einer Zeit, in der sich die persönliche Religiosität besonders vernehmlich artikulierte und die deshalb „the age of personal piety“ genannt worden ist, werden im Vortrag Gottesvorstellung und Gottesbeziehung des Mannes exemplarisch dargestellt, der den Gedenkstein gestiftet hat. Außerdem kann aus den zahlreichen Quellen mit religiöser Zweckbestimmung, die der Angehörige der Mittelklasse hinterlassen hat, sein Verhältnis zu 32 Göttern und Göttinnen rekonstruiert werden. Es erweist sich als differenziert, insofern jeder Gottheit eine spezifische Rolle im persönlichen Pantheon des Stifters zukam. Dass es ein dynamisches Verhältnis war, geht aus dem Vergleich mit zeitgenössischen Frommen hervor, die viele dieser Rollen anders besetzt oder sich andere Gottheiten erwählt haben. Das Problem, das die polytheistische Frömmigkeit für die Ägyptologen darstellt, scheinen die Alten Ägypter jedenfalls nicht gehabt zu haben.

Vortrag am 9.11.2012

Norbert Frei (Jena), Mitglied der Philologisch-historischen Klasse

Dr. phil. habil., Professor für Neuere und Neueste Geschichte an der Friedrich-Schiller-Universität Jena und Leiter des Jena Center Geschichte des 20. Jahrhunderts; am 11. Februar 2011 zum Ordentlichen Mitglied gewählt.

Forschungsgebiete: Neuere und Neueste Geschichte, Geschichte des Nationalsozialismus, Geschichte der Bundesrepublik Deutschland

Zeitgeschichte und Zeitzeugenschaft. Anmerkungen zu einem Spannungsverhältnis

Seit ihrer in Erfahrung des „Dritten Reiches“ begründeten „Erfindung“ im ersten Jahrzehnt nach dem Zweiten Weltkrieg steht die Zeitgeschichtsforschung in der Kritik einer nicht hinreichenden methodischen und theoretischen Fundamentierung. Ein wichtiger Aspekt war dabei stets ihr Umgang mit der zeitlichen Nähe zu ihrem Gegenstand. Diese Frage hat in den letzten Jahren neue Aktualität erfahren: Zum einen angesichts der inzwischen geradezu omnipräsenten, medial vermittelten Figur des „Zeitzeugen“, zum anderen aufgrund einer wachsenden Bereitschaft, auch Themen diesseits der in der Regel dreißigjährigen Archivsperre aufzugreifen, wodurch die eigene Zeitgenossenschaft des Forschenden wieder stärker ins Spiel kommt.

Der Vortrag diskutiert die Veränderungen im Verhältnis von Zeitgeschichte und Zeitzeugenschaft seit 1945 und fragt nach den Möglichkeiten einer NS-Forschung als Zeitgeschichte ohne Zeitzeugenschaft.

Vortrag am 9.11.2012

Wilfried Hofmann (Dresden), Mitglied der Technikwissenschaftlichen Klasse

Dr.-Ing., Professor für Elektrische Maschinen und Antriebe, Geschäftsführender Direktor des Elektrotechnischen Instituts, TU Dresden; seit 2006 Mitglied der Technikwissenschaftlichen Klasse, seit 2012 Sekretar, seit 2009 Mitglied der Deutschen Akademie der Technikwissenschaften – acatech.

Hauptarbeitsgebiete: Entwurf und Optimierung elektrischer Maschinen, Maschinenumrichter und -regelungen, Magnetlagertechnik, Leistungselektronik, Anwendungen in Wind- und Wasserkraftanlagen sowie in Elektro- und Hybridfahrzeugen

Elektromaschinen – Stand und Perspektiven unter den Aspekten von Energieeffizienz und Materialeinsatz

Die elektrische Maschine hat seit ihrer ersten praktikablen Realisierung im Jahre 1834 durch Jacobi eine bemerkenswerte Entwicklung genommen. Ihrer Erfindung ging eine über drei Jahrzehnte dauernde Suche vieler bekannter Wissenschaftler (Oerstedt, Faraday, Ampere, Lenz u.a.) voraus. Zahllose Ingenieure (Siemens, Ferraris, Tesla, Dolivo-Dobrovolski u.a.) haben sie in den folgenden sechs Jahrzehnten vervollkommnet und damit die 2. Industrielle Revolution in Gang gesetzt. Heute werden in den industrialisierten Volkswirtschaften weit über 95% der gesamten Stromerzeugung durch Generatoren getragen und ca. 65% des in der Industrie verbrauchten Stromes durch Motoren zur Umwandlung in mechanische Energie benutzt.

Seit einem Jahrzehnt gibt es international ernsthafte Bemühungen, Industriemotoren bzgl. ihrer Wirkungsgrade zu standardisieren. Die dazu erarbeiteten Standards sehen eine Einteilung in bisher drei Wirkungsgradklassen (Standard-, hoher und Premium-Wirkungsgrad) vor, deren Erweiterung nach oben offen erscheint. Diese Verbesserungen werden aber bisher fast ausschließlich dadurch erkauft, dass mehr oder wertvolleres aktives Material wie Kupfer für Wicklungen sowie verlustärmere Elektrobleche und energiereiche Permanentmagnete zur Magnetflussführung und zur Magnetfelderregung verbaut werden. So wird eine Verlustreduktion um 20% durch einen um bis zu 25% erhöhten Materialeinsatz erkauft. Der Übergang auf permanentmagneterregte Maschinen ist eine seit Jahren geübte Praxis, sie stößt aber seit kurzem auf Marktengpässe bei der Beschaffung preisgünstiger Hochenergiemagnete. Diese bestehen aus Seltenerde-Metallen (Neodym bzw. Samarium), wo im Falle von Neodym sehr rare und teure Legierungselemente wie Dysprosium oder Terbium zur Temperaturstabilisierung beigemischt werden.

Die Rohstoffsituation erfordert es deshalb, die Forschungsarbeiten auf sparsamen Einsatz aktiver Materialien zu konzentrieren, ihre multifunktionale Verwendung auszuloten oder sogar mit neuartigen Maschinenprinzipien Permanentmagnete verzichtbar zu machen. Im Vortrag wird dieses Vorgehen am Beispiel von zwei Forschungsobjekten, eines Fahrmotors mit innovativer Querkühlung für einen Hybridbus und eines Leichtbaumotors nach dem Transversalflussprinzip für allgemeine Anwendungen, illustriert.

Vortrag am 12.10.2012

Eberhard Kallenbach (Stützerbach/ Thür.), Mitglied der Technikwissenschaftlichen Klasse

Dr.-Ing. habil., Professor i. R. für Mechatronik an der Technischen Universität Ilmenau; Prof. h. c. der Universität Novocerkassk (Russland); am 12. Januar1996 zum Ordentlichen Mitglied gewählt.

Forschungsgebiete: Mechatronik, Angewandte Magnetik, Magnetische Antriebssysteme, Condition Monitoring

Condition Monitoring – eine Technik zur Erhöhung der Zuverlässigkeit technischer Systeme

Technische Systeme bestimmen zunehmend die Lebensqualität und Sicherheit der Menschen in modernen Industriegesellschaften. Fehler in technischen Systemen können zu Havarien und zu Verlusten an Leib und Leben führen und sind zu vermeiden. Durch Verkettung einer immer größeren Anzahl von Aggregaten, Vorrichtungen und Spezialmaschinen in Automatisierungsanlagen werden die Schäden bei auftretenden zustandsbedingten Ausfällen immer größer. Dadurch wachsen die Ausfallzeiten und die Kosten.

Grundsätzlich ist es möglich, die Lebensdauer der Anlagen durch Steigerung der Lebensdauer der einzelnen Bestandteile, Funktionsgruppen und Teilsysteme immer weiter zu erhöhen. Man stößt dabei aber an finanzielle Grenzen, da sowohl der Verschleiß und die Lebensdauer der einzelnen Teilsysteme unterschiedlich sind. Eine auf einen einheitlichen Zeitraum begrenzte Instandhaltung kann ökonomisch nicht vertreten werden.

In dem von mir seit 20 Jahren geleiteten Steinbeis-Transferzentrum Mechatronik (STZ Mechatronik) in Ilmenau wird an Maßnahmen gearbeitet, die Sicherheit technischer Antriebssysteme zu erhöhen.

Alle bekannten technischen Systeme haben eine begrenzte Gebrauchsdauer, die weitgehend von ihrer Entwicklung, ihrer Benutzung und Beanspruchung sowie von den unterschiedlichen Lebensdauern der einzelnen Teilsysteme abhängen.

Ein wirksames Mittel, um Schäden durch Ausfälle technischer Produkte zu vermeiden, ist die Methode der Zustandsbeobachtung (Condition Monitoring)bei laufendem Betrieb des technischen Systems. Auftretende Änderungen von Komponenten und Teilsystemen können damit rechtzeitig, noch vor dem Ausfall, erkannt werden.

Im STZ Mechatronik Ilmenau sind in Zusammenarbeit mit dem Fachgebiet Mechatronik der Technischen Universität Ilmenau ein Messprinzip und das Messgerät MagHyst entwickelt worden, das die Zustandsbestimmung von Antriebselementen, die auf dem Reluktanzprinzip beruhen, während der Produktion dieser Antriebselemente und in deren Betrieb zu bestimmen gestatten. Durch Messung des positionsabhängigen verketteten magnetischen Flusses können sowohl Fehler in den Erregerwicklungen z. B. durch Windungsschlüsse, am magnetischen Kreis durch fehlerhafte Montage oder mechanischen Verschleiß sowie Laständerungen infolge von Federbrüchen, Verklemmen von Kolbenschiebern in Ventilen rechtzeitig erkannt werden.

Der besondere Vorteil des Messgerätes MagHyst besteht darin, dass es eine große Anzahl von Einzelgrößen zu messen gestattet, die für die Beurteilung des Magnetzustandes, der Magnetbelastung, der Ankerposition und der Ankergeschwindigkeit wichtig sind. Auftretende Fehler können in der Fertigung von Magnetaktoren während der Montage, aber auch im späteren Einsatz gemessen werden. Verschleißerscheinungen am Magnetkreis und Veränderungen der Steuersignale können ebenfalls leicht erkannt werden.

Besonders wertvoll sind der Nachweis von verschleißbedingten Radialkräften, belastungsbedingten Luftspaltänderungen, wobei auch eine Einschätzung des zeitlich bedingten Fortschreitens des Verschleißes eine individuelle Lebensdauerabschätzung zulässt.

Zurzeit arbeiten wir im STZ Mechatronik daran, das Messgerät so zu verkleinern, dass es in Magnetantriebe bzw. Magnetaktoren integriert werden kann.

Literaturstellen:

[1] Kallenbach, E. u. a.: Elektromagnete. Grundlagen, Berechnungen, Entwurf und Anwendung. Vieweg + Teubner Verlag/Springer Fachmedien Wiesbaden GmbH, 4., überarbeitete und erweiterte Auflage 2012

[2] Kallenbach, E.: Der Gleichstrommagnet. Leipzig Akademische Verlagsgesellschaft Geest & Portig 1969

[3] Glet, U.: Schutzrecht DE 10 2005 0110227 A1 (11.3.2005)

Vortrag am 12.10.2012

Manfred Wendisch (Leipzig), Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Dr. rer. nat., Professor für Meteorologie an der Universität Leipzig, Direktor des Leipziger Instituts für Meteorologie und Leiter der Arbeitsgruppe Atmosphärische Strahlung; am 11. Februar 2011 zum Ordentlichen Mitglied gewählt.

Klimaänderungen in der Arktis: Einfluss von Wolken und Atmosphärischer Strahlung

Der Vortrag gibt eine Zusammenfassung zu ausgewaehlten, offenen wissenschaftlichen Fragen der Klima- und Wolkenforschung in der Arktis. Es werden Methoden vorgestellt, wie diese Fragen mit Hilfe von Flugzeuggetragenen Messungen bearbeitet werden koennen. Der Schwerpunkt des Vortrages liegt auf der Erkennung von Eis in unterkuehlten arktischen Mischphasenwolken. Dazu werden mehrere Verfahren vorgestellt, die auf Messungen der reflektierten spektralen Sonnenstrahlung ueber den Wolken beruhen. Spezielle Messbeispiele werden vorgestellt, wobei auch direkte Eismessungen in der Wolke einbezogen werden. Am Schluss des Vortrages werden Moeglichkeiten fuer die Verifikation solcher indirekten Messverfahren diskutiert.

Vortrag am 8.6.2012

Rudolf Holze (Chemnitz), Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Dr. rer. nat., Professor für Physikalische Chemie/Elektrochemie an der Technischen Universität Chemnitz, am 11. Februar 2011 zum Ordentlichen Mitglied gewählt.

Forschungsgebiete: Physikalische Chemie, Elektrochemie, Spektroskopie, Materialwissenschaften, Energiespeicherung und -wandlung

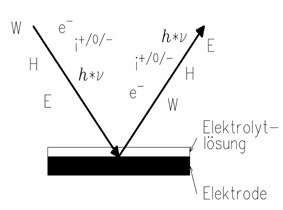

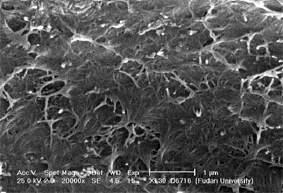

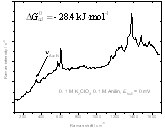

Elektrochemie: Von spektroskopischen Sonden zu Energiespeichern

Die Elektrochemie als Wissenschaft der Chemie und Physik geladener Teilchen unter Einwirkung elektrischer Felder hat in für eine extrem interdisziplinäre Disziplin typischer Weise aus der Adaption vielfältiger spektroskopischer und oberflächenanalytischer Methoden bemerkenswerte Erkenntnisfortschritte bei der Bearbeitung zahlreicher Aufgabenstellungen gewonnen. Dies gilt insbesondere beim konzertierten Einsatz von Methoden, bei dem sich Verfahren und Ergebnisse ergänzen und bekräftigen. Dies wird an ausgewählten Beispielen vor allem von Untersuchungen der elektrochemischen Doppelschicht aufgezeigt. Besonderer Wert wird dabei auf den in situ-Einsatz gelegt, der experimentelle Artefakte durch Probentransfers vermeidet. Diese Bedingung schränkt zwar die Auswahl unter den zur Verfügung stehenden Sonden und Signalen (←) drastisch ein, die verbleibende Methodenvielfalt hat sich dennoch als sehr wirkungsvoll erwiesen. In den letzten Jahren hat sich das Interesse der Elektrochemiker von Untersuchungen von Struktur und Dynamik dieser Doppelschicht, die in zahlreichen Zweigen der Elektrochemie an den Grenzen zu anderen Wissenschaften von großer Bedeutung für das Verständnis dort stattfindender Prozesse ist, zu elektrochemischen Materialwissenschaften verlagert. In jüngster Zeit ist dies mit nahezu euphorisch aufgenommenen Arbeiten zur elektrochemischen Energiespeicherung und -wandlung vor allem am Beispiel der Lithiumionenbatterien populär geworden. Die Realität dieser Materialwissenschaften ist wesentlich breiter und berührt wiederum zahlreiche andere Wissenschaftsfelder. Der Einsatz spektroelektrochemischer Methoden unter möglichst wirkungsnahen in situ-Bedingungen ist hier experimentell schwieriger. Aus der Untersuchung intrinsisch leitfähiger Polymere als einer recht jungen Materialklasse werden erfolgreiche Beispiele gezeigt, die zu Arbeiten an elektrochemischen Energiewandlern und -speichern überleiten.

Vortrag am 8.6.2012

Gerlinde Huber-Rebenich (Bern), Mitglied der Philologisch-historischen Klasse

Dr. phil., Professorin für Lateinische Philologie am Institut für Klassische Philologie der Universität Bern; am 8. Februar 2002 zum Ordentlichen Mitglied gewählt, seit 8. Oktober 2010 Korrespondierendes Mitglied; Mitglied der Projektbegleitenden Kommission für das Althochdeutsche Wörterbuch, das Etymologische Wörterbuch des Althochdeutschen und das Projekt „Deutsche Wortfeldetymologie in europäischem Kontext“. Forschungsprojekte: Repertorium der textbegleitenden Druckgraphik zu Ovids Metamorphosen'.

Ovid-Rezeption im lateinischen Mittelalter: Die 'Expositio' des Giovanni del Virgilio; Humanismus und Reformation.

Ovids "Metamorphosen" in Text und Bild: französische und italienische Drucke des 15. und 16. Jahrhunderts Die ovidischen Verwandlungssagen gehören zu den wirkmächtigsten Stoffen der abendländischen Tradition. Obwohl aufgrund des allzu menschlichen Verhaltens der antiken Götter und Heroen auf den ersten Blick nicht für den Schulunterricht geeignet – schon gar nicht für den Unterricht in Klosterschulen – haben sie nicht zuletzt dank der allegorischen Auslegungen, die ihnen zuteil wurden, das Mittelalter überlebt, um zusammen mit anderen Ovidiana in der sog. Renaissance des 12. Jahrhunderts ein wichtiger Referenztext für Dichter und Gelehrte zu werden und erst recht ab der "richtigen" Renaissance in Italien Literatur, Kunst und Festkultur maßgeblich zu beeinflussen. Ihre Kenntnis wurde nicht nur durch das lateinische Original vermittelt, sondern auch durch verschiedene Bearbeitung des Stoffes und ihre Übertragung in die Volkssprachen. Diese erschienen bereits ab dem Ende des 15. Jahrhunderts – zum Teil in hoher Auflagenzahl – in gedruckten Ausgaben, die häufig von Holzschnitten begleitet wurden. Auf diese Weise entstand innerhalb weniger Jahrzehnte ein relativ weit verbreitetes und leicht zugängliches "Bildarchiv", das die visuelle Vorstellung von den betreffenden Sagen mitprägte und auch inspirierend auf andere Kunstgattungen wirkte. Die frühen Illustrationszyklen, die sich zunächst in Frankreich und in Italien durchsetzten, stehen in engem Zusammenhang mit den Texten, die sie begleiten. Diesen Zusammenhang herauszuarbeiten und die Funktion der Bilder in ihrem jeweiligen Kontext zu bestimmen, ist Gegenstand meines Vortrages. Dabei beziehe ich mich vor allem auf die Tradition der Holzschnittserien, die für die sog. "Bible des poetes" (Brügge: Colard Mansion 1484) und für den "Ovidio metamorphoseos vulgare" des Giovanni dei Bonsignori (Venedig: Zoane Rosso fuer Lucantonio Giunta 1497) geschaffen wurden.

Vortrag am 11.5.2012

Bruno Klein (Dresden), Mitglied der Philologisch-historischen Klasse

Dr. phil. habil., Inhaber der ehemaligen Stiftungsprofessur für „Christliche Kunst der Spätantike und des Mittelalters“ an der Philosophischen Fakultät der Technischen Universität Dresden, derzeit deren Dekan; am 11. Februar 2011 zum Ordentlichen Mitglied gewählt, Vorsitzender der Strukturbezogenen Kommission für die Kunstgeschichte Mitteldeutschlands.

Forschungsgebiete: Geschichte der Architektur, der mittelalterlichen Kunst und der Kunstgeschichte

Mittelalterliche Kirchen im Bau – Chancen und Risiken

Große mittelalterliche Kirchen waren Projekte, deren Realisierung aufgrund ihrer Dimensionen nicht selten mehrere Jahrzehnte, wenn nicht gar Jahrhunderte dauern konnte. Während dieser langen Perioden konnte viel geschehen, was bei der Planung oder der Grundsteinlegung solcher Großbauten kaum absehbar war. In dem Vortrag wird speziell die Frage nach den Konsequenzen gestellt, die sich aus den Veränderungen von politischen, gesellschaftlichen und mentalen Figurationen ergeben konnten. Wie reagierte die Baustelle darauf, konkret: Auftraggeber, Organisatoren, Geldgeber, Werkmeister, Handwerker oder Gläubige? Gab es ästhetische Folgen? Und wenn ja, wurden solche zugelassen, vermieden oder gar forciert? Und darüber hinaus – trug eine einmal eröffnete Großbaustelle eher zur sozialen Dynamisierung oder zur Stabilisierung bei? Einige der unterschiedlichen Optionen sollen exemplarisch anhand der gotischen Kathedralen von Straßburg, Köln und Prag dargestellt werden. Thesenhaft wird dabei erörtert, dass die formale und stilistische Vereinheitlichung von Großbauten, wie sie seit der Neuzeit üblich ist, insbesondere auf einer Strategie zur Bewältigung jener Kontingenzen beruht, welche mittelalterlichen Großbauten immanent war.

Vortrag am 11.5.2012

Frank Steglich (Dresden), Mitglied der Technikwissenschaftlichen Klasse

Dr. rer. nat., Professor für Physik, Gründungsdirektor des Max-Planck-Instituts für Chemische Physik fester Stoffe (CPfS) Dresden; am 12. Februar 1999 zum Korrespondierenden Mitglied der Technikwissenschaftlichen Klasse gewählt; seit April 2012: kommissarischer Leiter des Forschungsbereiches Festkörperphysik am MPI-CPfS, Qiushi Distinguished Professor and Director of the Center for Correlated Matter (CCM) at Zhejiang University, Hangzhou (China), Distinguished Visiting Professor at the Institute of Physics (IOP), Chinese Academy of Sciences (CAS), Beijing (China).

Hauptarbeitsgebiete: Experimentelle Festkörperphysik – Magnetismus, Supraleitung, Thermoelektrizität, Unordnungsphänomene

100 Jahre Festkörperforschung: von klassischer zu unkonventioneller Supraleitung

Das Phänomen der Supraleitung, 1911 durch Kamerlingh-Onnes in Leiden entdeckt, konnte erst 1957 durch Bardeen, Cooper und Schrieffer (BCS) mikroskopisch gedeutet werden. Danach wird das System der Leitungselektronen im Metall beim Abkühlen unter die Übergangstemperatur Tc durch die Bildung von Elektronenpaaren instabil. Diese „Cooperpaare“, die den elektrischen Strom verlustfrei tragen, entstehen infolge einer elastischen Kopplung von je zwei Leitungselektronen. Allerdings führen bereits sehr geringe Konzentrationen magnetischer Fremdatome zum Aufbrechen der Cooperpaare, d.h. zur Zerstörung der Supraleitung. 1977 wurden in meiner Arbeitsgruppe erstmalig Anzeichen für Supraleitung in der Verbindung CeCu2Si2 beobachtet, in welcher Cer dreiwertig vorliegt. Jedes Ce3+ trägt ein lokales magnetisches Moment. Wie in der Publikation von 1979 gezeigt, werden hier 100% magnetischer Atome zur Erzeugung des supraleitenden Zustandes benötigt. Kürzlich durchgeführte, hochempfindliche Untersuchungen der inelastischen Neutronenstreuung beweisen, dass der Paarbildungsmechanismus in dieser Verbindung tatsächlich magnetischer Natur ist. CeCu2Si2 ist somit der erste von mehr als 100 heute bekannten „unkonventionellen Supraleitern“. Zu diesen gehören auch die 1986 von Bednorz und Müller entdeckten Kupratverbindungen mit Übergangstemperaturen bis Tc ≈ 164 K. Ziel der aktuellen Forschung sind „Raumtemperatur-Supraleiter“, von denen man sich große Fortschritte in den Bereichen Energie- und Informationstechnologie verspricht.

Festvortrag zur Öffentlichen Frühjahrssitzung am 20.4.2012

André Wagenführ (Dresden), Mitglied der Technikwissenschaftlichen Klasse

Dr.-Ing., Professor für Holz- und Faserwerkstofftechnik an der Technischen Universität Dresden; am 20. März 2006 zum Ordentlichen Mitglied gewählt.

Die stoffliche Holzverwendung in Vergangenheit, Gegenwart und Zukunft

Die Holzverwendung ist eng mit der Menschheitsgeschichte verbunden. Während in der Frühzeit Holz für den persönlichen Gebrauch insbesondere als Bau- und Brennstoff unverzichtbar war, wurde seit der Industrialisierung und nach dem Zweiten Weltkrieg Holz von anderen Materialien wie Kunststoffen, Stahl, Beton und fossilen Energieträgern stark zurückgedrängt. Allerdings konnte vor über 100 Jahren mit dem Aufkommen der ersten Holzwerkstoffe dem Wunsch nach Verminderung der Anisotropie und Heterogenität des Naturstoffes Holz deutlich besser entsprochen und die Entwicklung neuartiger Produkte aus Holz ermöglicht werden. Heute im Zeitalter des Übergangs von fossilen zu nachwachsenden Ressourcen wird Holz als nachhaltiger und ökologischer Rohstoff wiederentdeckt. Holz ist zudem vielseitig verwendbar und multifunktional: zuerst Bau- und Werkstoff, am Schluss Brennstoff im Sinne einer Kaskadennutzung. Als Baustoff für Häuser und im Ingenieurholzbau, als Werkstoff für den Möbel- und Innenausbau sowie als Grundlage für Zellstoff und Papier steht Holz in direktem Kontakt mit dem Menschen. Die verstärkte Nutzung des Holzes als ein von der Natur über Jahrmillionen optimierter Bau- und Werkstoff, z.B. über die Entwicklung neuer, ressourcen- und energieeffizienter Technologien, Werkstoffe und Konstruktionen, ist Aufgabe der Forschung von heute und morgen.

Vortrag am 9.3.2012

Stefan Odenbach (Dresden), Mitglied der Technikwissenschaftlichen Klasse

Dr. rer. nat. habil., Professor für Magnetofluiddynamik an der Fakultät Maschinenwesen der Technischen Universität Dresden; am 8. Februar 2008 zum Ordentlichen Mitglied gewählt.

Forschungsgebiete: Strömungsmechanik komplexer Fluide, Rheologie, Messtechnik

Röntgen-Mikrotomographie als Werkzeug der Ingenieurwissenschaften – und darüber hinaus

Seit der Entdeckung der Röntgenstrahlung durch Conrad Röntgen vor fast 120 Jahren haben sich radiographische Verfahren als unverzichtbares Werkzeug in Medizin und Technik bei der Untersuchung der inneren Struktur opaquer Objekte einen festen Platz gesichert. Mit der Weiterentwicklung der Rechentechnik wurde die klassische Radiographie Anfang der 70er Jahre des vergangenen Jahrhunderts durch die Röntgen-Computertomographie ergänzt, die es erlaubt, dreidimensionale Repräsentationen der untersuchten Objekte herzustellen. In der technischen Weiterentwicklung der Computertomographie hat in den vergangenen Jahren die Röntgen-Mikrotomographie, mittels derer an Objekten mit Kantenlängen im cm Bereich räumliche Auflösungen von einigen µm erzielt werden können, als Werkzeug für technische Fragestellungen eine enorme Entwicklung erfahren.

Insbesondere in Kopplung mit Verfahren der digitalen Bildbearbeitung können aus den dreidimensionalen Datensätzen statistisch gesicherte Informationen über die innere Struktur von Objekten gewonnen werden.

Nach einer kurzen Vorstellung der grundlegenden Arbeitsprinzipien der Mikrotomographie soll die Breite der möglichen Untersuchungen an drei Beispielen kurz herausgestellt werden. Dabei wird neben der mikrostrukturellen Charakterisierung neuer Materialien und einem Problem aus der Verfahrenstechnik eine medizintechnische Fragestellung im Vordergrund stehen. An diesem letzten Beispiel sollen die Probleme der Materialidentifikation bei der Röntgentomographie mittels Röntgenröhren aufgezeigt und ein Lösungsansatz über die Kalibration mit Phantomsystemen diskutiert werden.

Vortrag am 9.3.2012

Jürgen Haase (Leipzig), Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Dr. rer. nat., Professor für Experimentalphysik/ Festkörperphysik an der Universität Leipzig, am 11. Februar 2011 zum Ordentlichen Mitglied gewählt.

Forschungsgebiete: Experimentelle Physik, Elektronische Eigenschaften von Festkörpern, Physikalische Chemie poröser Materialien, Entwicklung der Magnetischen-Resonanz-Spektroskopie Elektronisches

Leben in Festkörpern – Leipziger Einblicke und Ansichten

Der unendlichen Vielfältigkeit von Festkörpern, sieht man sie als Gemische von Atomen verschiedenster Art oder Anordnung beim Aufbau, stehen fundamentale Phänomene gegenüber, die nahezu unabhängig von strukturellen Kleinigkeiten existieren. Sie machen einen Festkörper z.B. zu einem elektrischen Leiter, den wir als sehr verlässlichen Begleiter kennen. Einen, der Energie aus dem Kraftwerk zum Verbraucher bringt, Züge und Autos fahren lässt, Flugzeuge steuert, oder gar manchem Herz den Ton angibt.

Theoretische Modelle, die dieses Phänomen erklären, scheinen dagegen nicht so stabil zu sein. Paul Drude postulierte 1900 in Leipzig, kurz nach der Entdeckung der Elektronen, dass diese als Gas den elektrischen Leiter relativ frei durchströmen, ein Bild, an das viele heute noch gern glauben. Felix Bloch zeigte 1928 in Leipzig, dass die Elektronen quantenmechanische (Bloch-) Wellen bilden, die mit nur geringem Widerstand durch den Festkörper gleiten. Damit war die Tür geöffnet, endlich auch z.B. die Halbleiter und die darauf basierenden Bauelemente (z.B. Transistoren) zu verstehen. Von Anbeginn, leider, taugte Blochs Theorie jedoch nicht zur Erklärung der Supraleitung (elektrischer Stromfluss völlig ohne Widerstand, bekannt seit 1911). Bloch kapitulierte, auch Einstein spekulierte erfolglos. Erst 1957 entdeckten Bardeen, Cooper und Schrieffer in Urbana IL, USA, eine ganz andere Theorie (BCS), die auch dieses fundamentale Phänomen erklärte. Vieles schien gelöst.

Der Magnetismus von Festkörpern, ein anderes Phänomen, war durch Werner Heisenbergs fundamentale Arbeiten in Leipzig fast erklärt (trotz bis heute offener Fragen). Frank Steglichs Supraleitung von schweren Fermionen (1979), und insbesondere die von K. Alex Müller und George Bednorz gefundene Hochtemperatur-Supraleitung (1986) belegten, dass die Verständnislücken wohl doch noch viel größer waren als geglaubt. Zum Beispiel zeigen sie, dass Magnetismus und Supraleitung, Erzfeinde für die BCS-Theorie, vielleicht doch friedlich nebeneinander leben können.

Heute wissen wir, dass elektronische Strukturen, selbst in wohldefinierten Festkörpern, mitunter sehr komplex sind. So können sie auf kleinste Änderungen empfindlich reagieren (das macht sie intelligent), oder Teile ihrer Eigenschaften können sich räumlich (z.B. im Nanometer-Bereich) drastisch ändern, während sie makroskopisch scharf definierte Phänomene zeigen, was an die molekulare Struktur des Lebens erinnert.

Bei der Untersuchung dieses „elektronischen Lebens“ in Festkörpern spielen geeignete Untersuchungsmethoden eine fundamentale Rolle. So auch eine Methode mit Leipziger Tradition (seit 1951), die zum großen Teil auf Felix Bloch zurückgeht, und immer wieder ungeahnte Einblicke in die Festkörperphysik gewährte, die Magnetische Resonanz. Heute kennt sie jeder, denn sie kann auch Einblicke in lebendige Körper geben und hilft sogar, unsere Gedanken zu verstehen.

Leipzig ist heute weltweit führend bei der Erforschung elektronischen Lebens in Festkörpern mit Extremer Magnetischer Resonanz. Denn um das „elektronische Gewebe“ beeinflussen zu können, benötigt man extrem hohe Drücke und Magnetfelder, die wir der Magnetischen Resonanz erst jetzt zur Verfügung stellen. Wir beobachten nun z.B. Blochs Wellen in einfachstem Aluminium-Metall und finden eine unerwartete Verformung der Fermi-Fläche unter Druck, die Helmut Eschrig et al. theoretisch erklären können. Obgleich man nicht weiß, welcher Art die Wellen oder Teilchen in Hochtemperatur-Supraleitern sind, können wir nun sagen, dass es zwei Sorten gibt, wohl geordnete und sehr ungeordnete; erstere könnten Blochs Wellen ähneln, letztere sind lokaler, vielleicht magnetischer Art. Unsere Arbeiten stützen auch neue Theorien, die komplexer Physik selbst mit Quantum-Chaos zu Leibe rücken. Soweit einige Beispiele.

Mit dem neu geöffneten Fenster in die lebendige Festkörperphysik werden Einsichten möglich, die theoretische Ansichten formen helfen und uns so beim Verständnis und der Nutzbarmachung dieser modernen, energie-relevanten Materialien voran bringen.

Vortrag am 10.2.2012

Klaus Bochmann (Leipzig), Mitglied der Philologisch-historischen Klasse

Dr. phil. habil., Professor i. R. für Romanische Sprachwissenschaft am Institut für Romanistik der Universität Leipzig; am 8. Februar 2002 zum Ordentlichen Mitglied gewählt, Vorsitzender der Sprachwissenschaftlichen Kommission;

Forschungsgebiete: Rumänische, italienische und französische Sprachwissenschaft, besonders Sprachgeschichte; historisch-vergleichende romanische Sprachwissenschaft; italienische Literaturgeschichte des 12. bis 16. Jahrhunderts; rumänische Literatur; Theorie der Soziolinguistik und Soziolinguistik der romanischen Sprachen.

Paris als (umkämpfter) Kommunikationsraum im XVI. Jahrhundert

Das 16. Jahrhundert ist für die Entstehung des heutigen Französischen von grundlegender Bedeutung. In Paris, dessen Stadtsprache seit dem Hochmittelalter das höchste Prestige unter allen französischen Varietäten genoß, entschied sich in diesem Zeitraum das Schicksal der künftigen Standardsprache Frankreichs und damit auch der internationalen Frankophonie. Vor dem Hintergrund konfessioneller Auseinandersetzungen zwischen reformatorischen Kräften und katholischen Mächten, politischer Konflikte zwischen Königtum und Partikulargewalten sowie kultureller Kämpfe zwischen traditionellem Gelehrtenmilieu, italianisierendem Hofadel und nationalem Bürgertum setzt sich im Verlaufe des Jahrhunderts das Konzept einer dem Absolutismus dienenden Sprachpolitik durch, die hinsichtlich der Sprachnorm als konservativ erscheint, hinsichtlich der Statusbestimmung jedoch dem Französischen den eindeutigen Vorrang vor den Konkurrenzsprachen Latein, Italienisch und Regionalsprachen Frankreichs einräumt.

Vortrag am 10.2.2012

Hans-Bert Rademacher (Leipzig), Mitglied der Mathematisch-naturwissenschaftlichen Klasse

Dr. rer. nat, Professor für Differentialgeometrie am Mathematischen Institut der Universität Leipzig, am 12. Februar 2010 zum Ordentlichen Mitglied gewählt;

Forschungsgebiete: Riemannsche und Pseudo-Riemannsche Geometrie, Morse-Theorie und Geschlossene Geodätische, Konforme Geometrie, Finsler-Geometrie, Geometrie des Dirac-Operators

Periodische Geodätische Linien

Auf einem gekrümmten Raum ist eine geodätische Linie eine Kurve, die zwischen nicht zu weit auseinander liegenden Punkten die kürzeste Verbindung ist. In diesem Sinne verallgemeinern die geodätischen Linien also die Geraden in der Euklidischen Geometrie des flachen Raums. Die geodätischen Linien auf der Oberfläche einer Kugel sind die Großkreise, d.h. in diesem Fall sind alle geodätischen Linien periodisch. Wie verhalten sich diese Linien aber, wenn wir wir diese Fläche deformieren, wie viele periodische geodätische Linien existieren dann? In dem Vortrag soll diskutiert werden, inwieweit qualitative Methoden benutzt werden können, um Aussagen über die Existenz und Stabilität von periodischen geodätischen Linien zu erhalten. Es zeigt sich, dass bei geschlossenen Räumen die Existenz von nur endlich vielen periodischen geodätischen Linien ein Resonzphänomen impliziert. Da geodätische Linien auch als Bahnkurven von Teilchen aufgefasst werden können, kann man mit Hilfe der Eigenschaften der periodischen Bahnen qualitative Eigenschaften des zu Grunde liegenden Dynamischen Systems beschreiben.

Vortrag am 13.1.2012

Hans-Werner Fischer-Elfert (Leipzig), Mitglied der Philologisch-historischen Klasse

Dr. phil. habil, Professor für Ägyptologie an der Universität Leipzig; am 12. Februar 2010 zum Ordentlichen Mitglied gewählt; Projektleiter des Akademieprojekts „Altägyptisches Wörterbuch“.

Forschungsschwerpunkte: Literatur, Magie und Medizin und Handschriftenkunde

Weisheit und Wissenschaft im Alten Ägypten – Gemeinsame Wiege, getrennte Wege

Aus der Epoche des sog. Mittleren Reiches (20.–18. Jh. v. Chr.) sind uns erstmalig literarische und wissenschaftliche Werke in Gestalt von Papyrushandschriften erhalten. Literatur im engeren Sinne umfaßt Gattungen wie Erzählungen, Klagen, Prophezeiungen, des Weiteren Sammlungen weisheitlicher Maximen für die rechte Amts- und Lebensführung, in der Ägyptologie auch Lebenslehren genannt. Zu regelrecht kodifizierter wissenschaftlicher Literatur gehören mathematische und medizinische Traktate. Astronomische Kenntnisse manifestieren sich noch in anwendungsorientierter Verschriftlichung, wie z.B. als Sternuhren auf Privatsärgen, nicht aber bereits in didaktischen Handbüchern.

Lebenslehren, die diagnostisch-therapeutisch orientierte Medizin und mathematische Werke diskutieren ihre Fallbeispiele bzw. Probleme stets in streng kasuistischer Einzelerörterung. Bei diesem Verfahren sind eine die Gattungen übergreifende und stilistisch-rhetorisch verblüffend übereinstimmende Argumentation und Phraseologie nicht zu übersehen. Diese sprachliche Koinzidenz kann als typisch für die frühe Weisheit und Wissenschaft im Alten Ägypten veranschlagt werden und spricht für eine gemeinsame Genese; konkrete Beispiele dazu wird der Vortrag liefern. Ein kurzer Ausblick auf die spätere, rhetorisch diversifizierte Formung der miteinander verglichenen Gattungen soll die Auseinanderentwicklung der genannten Großgattungen verdeutlichen. Diese Tendenz könnte auf eine zunehmende Spezialisierung im damaligen Wissenschaftsbetrieb hinweisen.

Vortrag am 13.1.2012

Eugen Georg Woschni (Dresden), Mitglied der Technikwissenschaftlichen Klasse

Dr.-Ing., Professor i. R. für Nachrichtentechnik an der Technischen Universität Chemnitz; am 11. Oktober 1985 zum Ordentlichen Mitglied der Mathematisch-naturwissenschaftlichen Klasse gewählt, seit 10. Mai 1996 Mitglied der Technikwissenschaftlichen Klasse.

Arbeitsgebiete: Informationstechnik; Messtechnik; Nachrichtentechnik

Näherungsbetrachtungen contra Computerlösungen ? – Ein Beitrag zur Diskussion über Lehrinhalte

Den Begründer der Schwachstromtechnik, meinen Lehrer Heinrich Barkhausen, erlebte ich oft in Diskussionen zu Vorträgen mit der Bemerkung: „Was Sie da gerechnet haben, habe ich alles nicht verstanden, aber das Ergebnis ist falsch.“ Mit einer einfachen Näherungsbetrachtung unter Zuhilfenahme physikalischer Überlegungen begründete er seine Aussage.

In der heutigen Ausbildung wird diese Art zu denken leider kaum noch gelehrt, wie ich auch aus langjährigen eigenen Vorlesungen zu Näherungsbetrachtungen weiß.

Während im Zeitalter des Rechenschiebers Näherungsbetrachtungen unerlässlich waren, da der Rechenschieber nur die Zahlenfolge ergab und daher die Größenordnung der Lösung durch Abschätzungen zu ermitteln war, liefert heute der Rechner die komplette Lösung. Trotzdem sind Überschlagsrechnungen auch heute notwendig:

So sollte man stets durch einen Überschlag prüfen, ob das Ergebnis stimmen kann, da man damit Fehler in der Programmierung erkennen kann.

Die Parameter der Bauelemente in der Mikroelektronik haben oft einen Toleranzbereich von einigen 10%. Durch schaltungstechnische Maßnahmen – z.B. Gegenkopplung – wird trotzdem ein stabiler Betrieb erreicht. Bei derartigen Toleranzen sind dann auch oft Näherungen für die Berechnung ausreichend.

Während die Computerlösung nur für die angenommenen speziellen Parameter gilt, erhält man mit Hilfe physikalisch-anschaulicher Näherungslösungen direkt die für die Anwendung in der Praxis erforderlichen allgemeingültigen Zusammenhänge.

Schließlich lassen sich allgemeine Gesetzmäßigkeiten oft bereits mit Näherungsbetrachtungen sehr anschaulich ableiten und deuten.

Im Vortrag werden diese Aussagen an typischen Beispielen demonstriert. Dabei werden auch neue Ergebnisse weitergehender Untersuchungen zu Problemen gewonnen, die in meinem letzten Akademievortrag als noch nicht zufriedenstellend gelöst genannt wurden.